deepseek 是由国内顶尖 ai 团队「深度求索」开发的多模态大模型,具备数学推理、代码生成等深度能力,被誉为"ai界的六边形战士"。

DeepSeek 拥有许多标签,其中最具代表性的有以下两个:

低成本(不挑硬件、开源) 高性能(推理能力极强、回答准确)

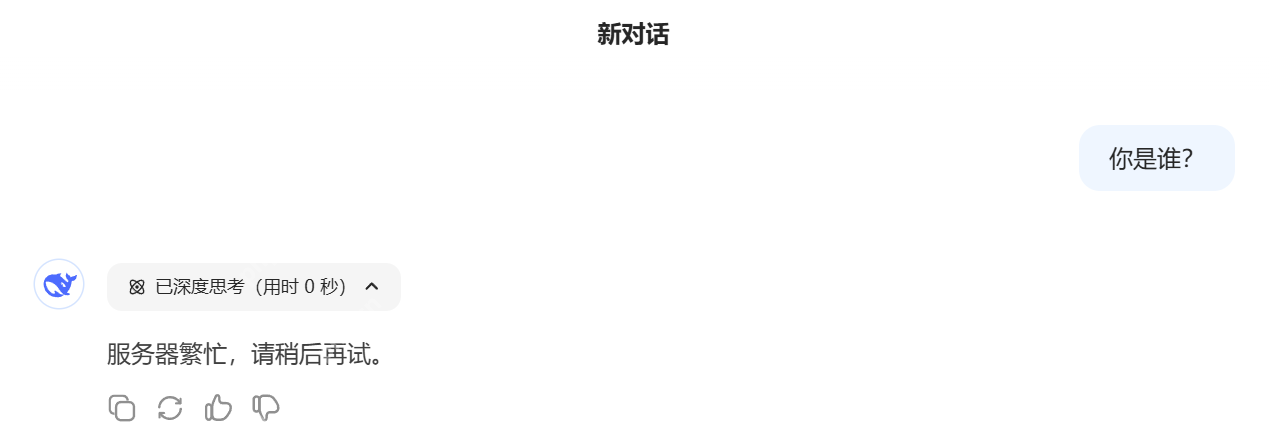

一、为什么要在本地部署 DeepSeek? 使用 DeepSeek 时,许多用户会遇到以下问题:

这是因为 DeepSeek 火爆后访问量激增,再加上来自国外的持续恶意攻击,导致其服务器不稳定。因此,在本地部署 DeepSeek 大模型就显得尤为重要。

这是因为 DeepSeek 火爆后访问量激增,再加上来自国外的持续恶意攻击,导致其服务器不稳定。因此,在本地部署 DeepSeek 大模型就显得尤为重要。

此外,对于一些敏感数据,用户不希望将其上传到网络,安全性是首要考虑的因素。本地大模型运行在用户自己的电脑上,完全不受网络影响,数据保存在本地,隐私性更高。同时,本地大模型可以根据用户需求进行定制,使用灵活性极强。

二、如何在本地部署大模型? 在本地部署 DeepSeek 只需以下三步:

- 安装 Ollama。

- 部署 DeepSeek。

- 使用 DeepSeek:这里我们使用 ChatBox 客户端操作 DeepSeek(此步骤非必须)。

Ollama、DeepSeek 和 ChatBox 之间的关系如下:

- Ollama 是“大管家”,负责将 DeepSeek 安装到用户的电脑上。

- DeepSeek 是“超级大脑”,在 Ollama 搭建的环境中运行,帮助用户完成各种任务。

- ChatBox 是“聊天工具”,让用户更方便地与 DeepSeek 交流。

安装 Ollama Ollama 是一个开源的大型语言模型服务工具,主要帮助用户在本地快速运行大模型。它简化了在 Docker 容器中部署和管理大语言模型(LLM)的过程。

PS:Ollama 就是大模型界的“Docker”。

Ollama 的优点包括:

- 易于使用:即使是没有经验的用户也能轻松上手,无需开发即可直接与模型进行交互。

- 轻量级:代码简洁,运行时占用资源少,能够在本地高效运行,不需要大量的计算资源。

- 可扩展:支持多种模型架构,并易于添加新模型或更新现有模型,还支持热加载模型文件,无需重新启动即可切换不同的模型,具有较高的灵活性。

- 预构建模型库:包含一系列预先训练好的大型语言模型,可用于各种任务,如文本生成、翻译、问答等,方便在本地运行大型语言模型。

Ollama 官网:https://www.php.cn/link/838dc9de386130f83f625a98d1ea561f

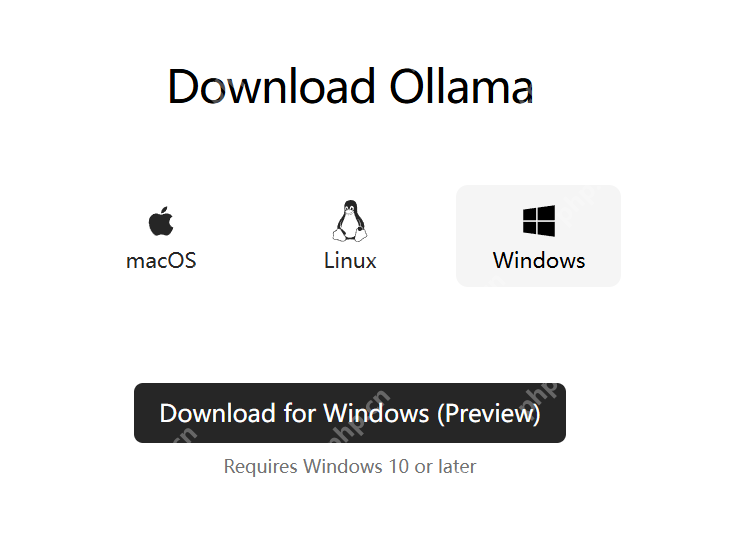

下载并安装 Ollama: 下载地址:https://www.php.cn/link/838dc9de386130f83f625a98d1ea561f

用户根据自己的操作系统选择对应的安装包,然后安装 Ollama 软件即可。

用户根据自己的操作系统选择对应的安装包,然后安装 Ollama 软件即可。

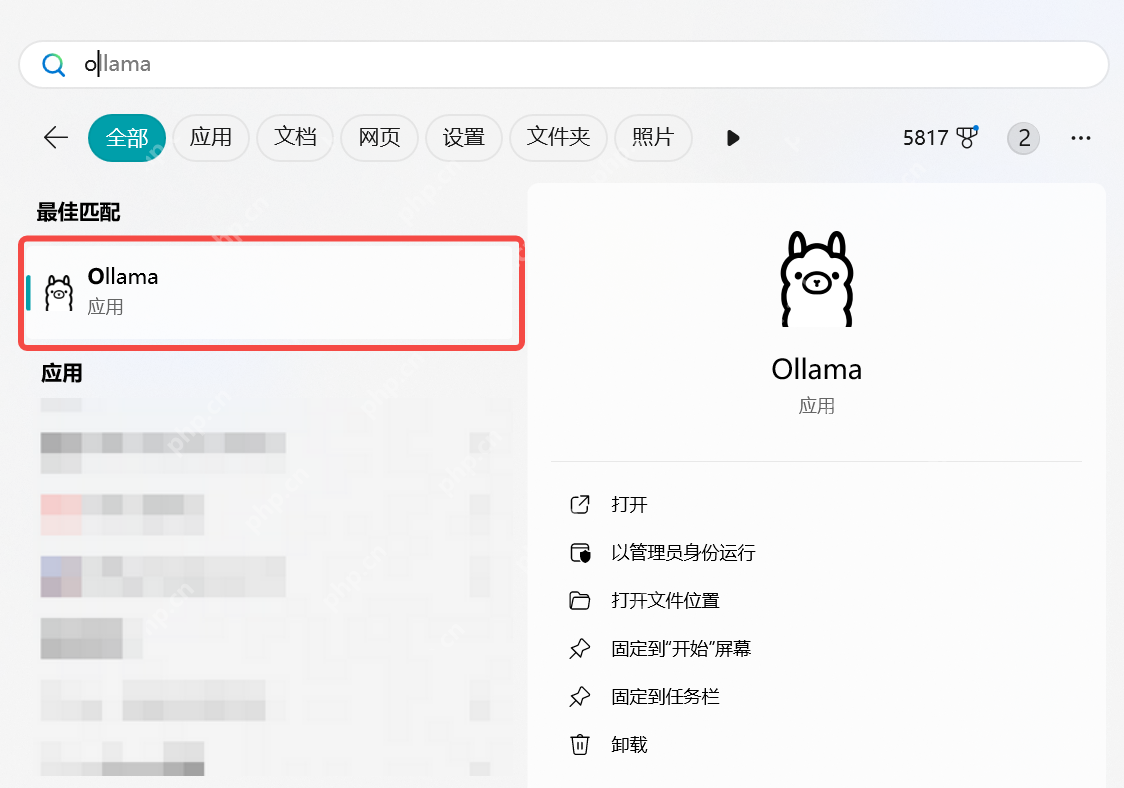

安装完成后,电脑上会出现一个 Ollama 应用:

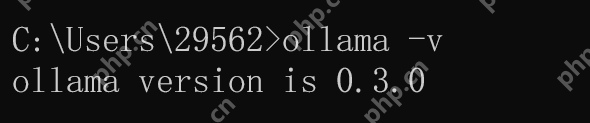

点击应用即可运行 Ollama,此时在电脑状态栏可以看到 Ollama 的小图标。要测试 Ollama 是否安装成功,使用命令窗口输入“ollama -v”指令,如果能正常响应并显示 Ollama 版本号,就说明安装成功了,如下图所示:

点击应用即可运行 Ollama,此时在电脑状态栏可以看到 Ollama 的小图标。要测试 Ollama 是否安装成功,使用命令窗口输入“ollama -v”指令,如果能正常响应并显示 Ollama 版本号,就说明安装成功了,如下图所示:

部署 DeepSeek Ollama 支持的大模型列表:https://www.php.cn/link/838dc9de386130f83f625a98d1ea561flibrary

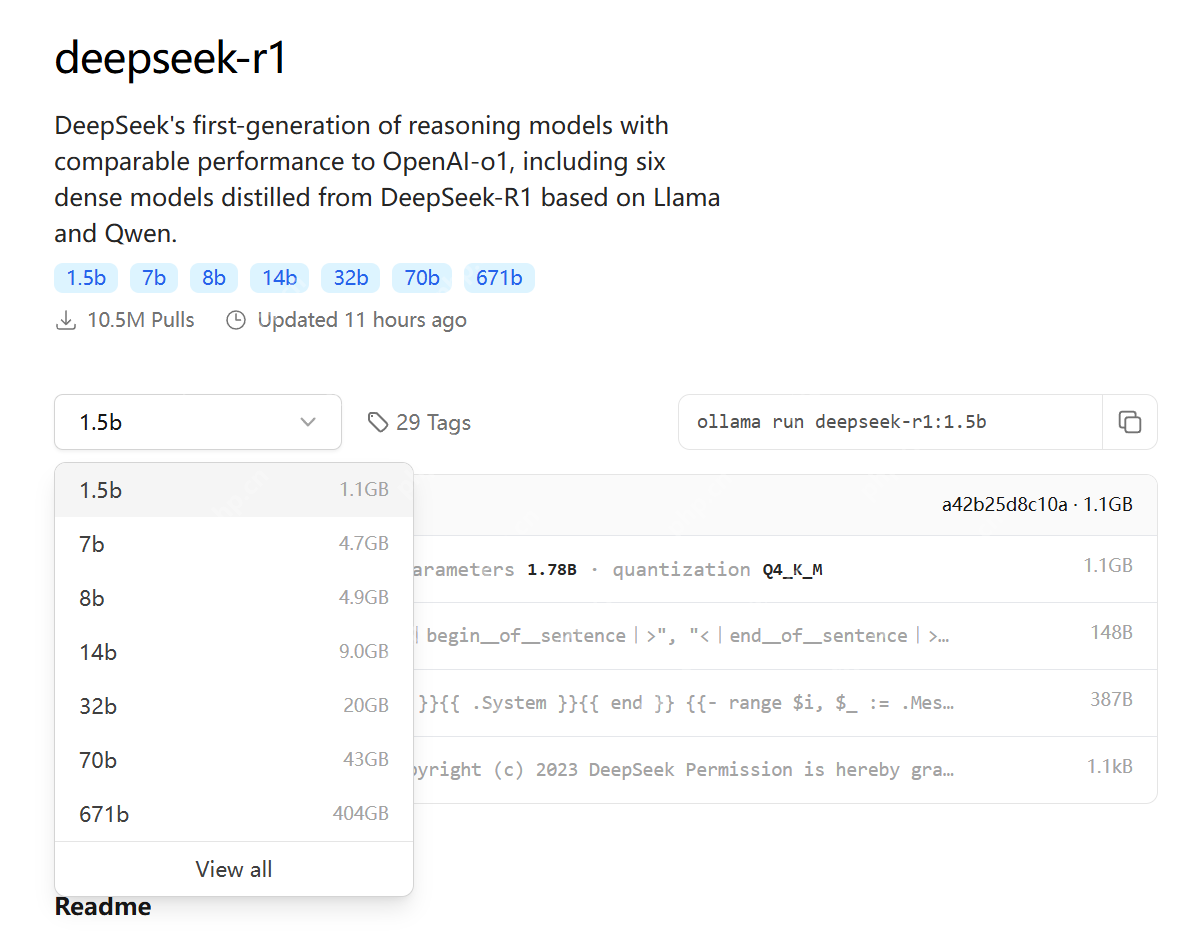

选择 DeepSeek 大模型版本,如下图所示:

DeepSeek 版本介绍

| 模型参数规模 | 典型用途 | CPU 建议 | GPU 建议 | 内存建议 (RAM) | 磁盘空间建议 | 适用场景 |

|---|---|---|---|---|---|---|

| 1.5b (15亿) | 小型推理、轻量级任务 | 4核以上 (Intel i5 / AMD Ryzen 5) | 可选,入门级 GPU (如 NVIDIA GTX 1650, 4GB 显存) | 8GB | 10GB 以上 SSD | 小型 NLP 任务、文本生成、简单分类 |

| 7b (70亿) | 中等推理、通用任务 | 6核以上 (Intel i7 / AMD Ryzen 7) | 中端 GPU (如 NVIDIA RTX 3060, 12GB 显存) | 16GB | 20GB 以上 SSD | 中等规模 NLP、对话系统、文本分析 |

| 14b (140亿) | 中大型推理、复杂任务 | 8核以上 (Intel i9 / AMD Ryzen 9) | 高端 GPU (如 NVIDIA RTX 3090, 24GB 显存) | 32GB | 50GB 以上 SSD | 复杂 NLP、多轮对话、知识问答 |

| 32b (320亿) | 大型推理、高性能任务 | 12核以上 (Intel Xeon / AMD Threadripper) | 高性能 GPU (如 NVIDIA A100, 40GB 显存) | 64GB | 100GB 以上 SSD | 大规模 NLP、多模态任务、研究用途 |

| 70b (700亿) | 超大规模推理、研究任务 | 16核以上 (服务器级 CPU) | 多 GPU 并行 (如 2x NVIDIA A100, 80GB 显存) | 128GB | 200GB 以上 SSD | 超大规模模型、研究、企业级应用 |

| 671b (6710亿) | 超大规模训练、企业级任务 | 服务器级 CPU (如 AMD EPYC / Intel Xeon) | 多 GPU 集群 (如 8x NVIDIA A100, 320GB 显存) | 256GB 或更高 | 1TB 以上 NVMe SSD | 超大规模训练、企业级 AI 平台 |

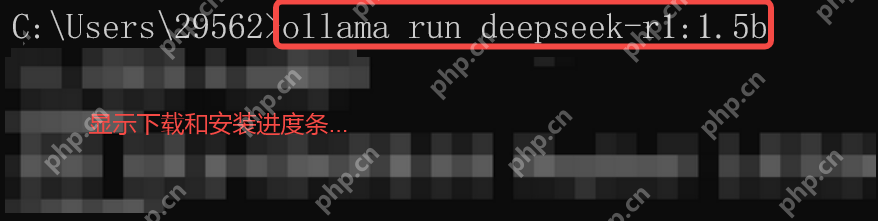

例如,安装并运行 DeepSeek:ollama run deepseek-r1:1.5b

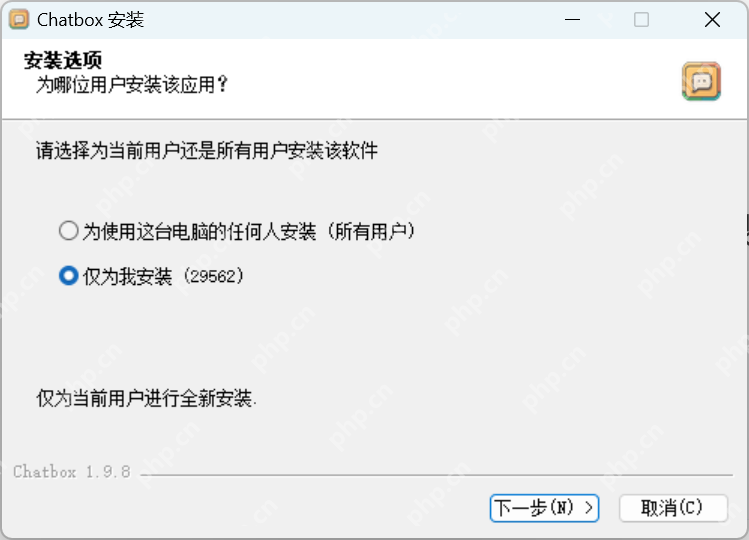

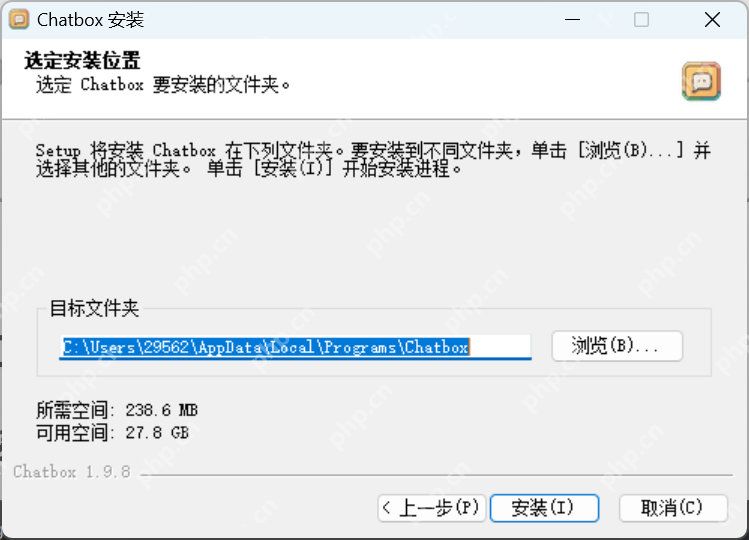

使用 DeepSeek 这里我们使用 ChatBox 调用 DeepSeek 进行交互,ChatBox 是一个前端工具,用于方便地对接各种大模型(包括 DeepSeek),并且它支持跨平台,使用直观易用。

ChatBox 官网地址:https://www.php.cn/link/de487db7a08250a136f966ead11da262

点击下载按钮获取 ChatBox 安装包:

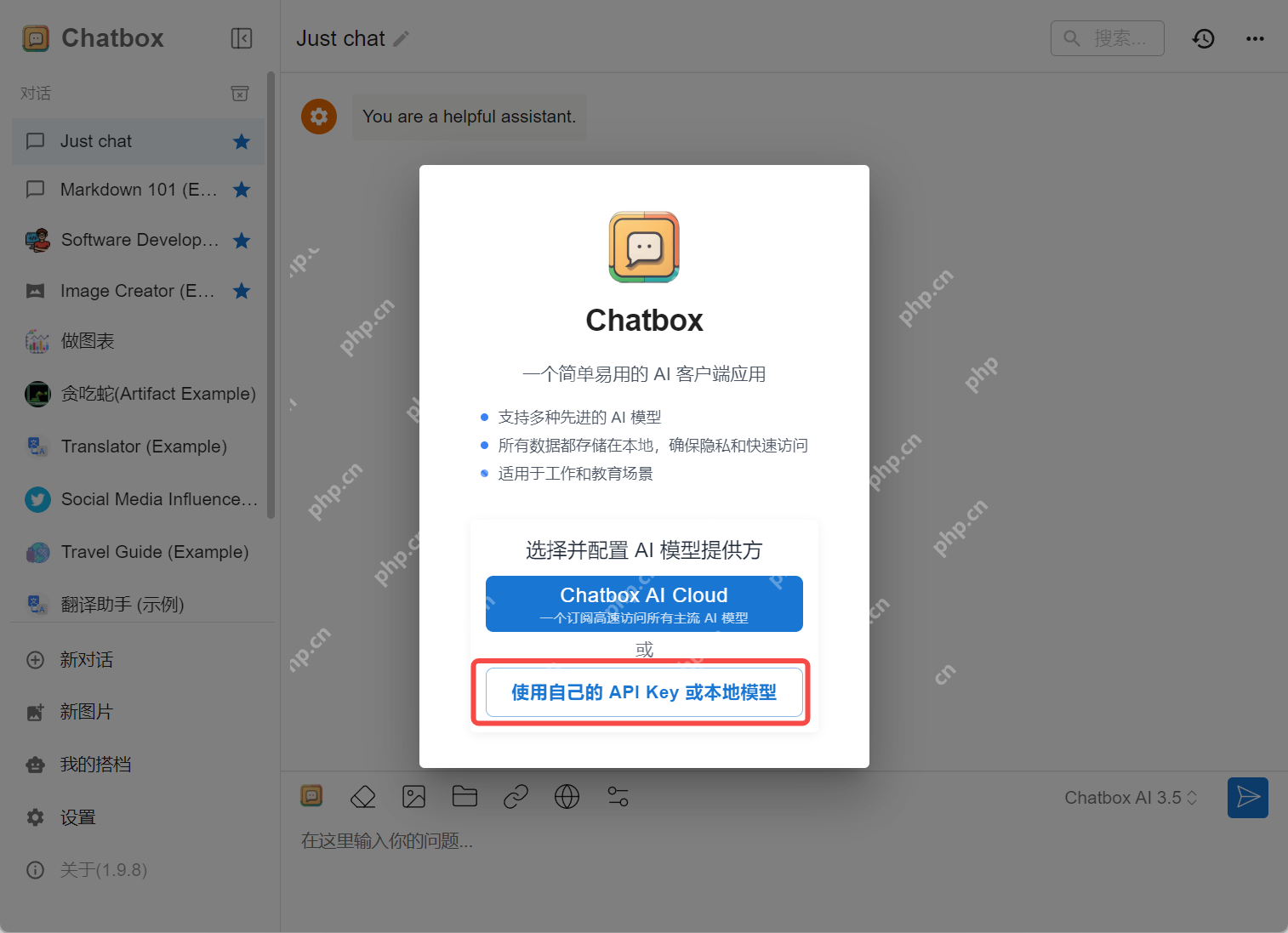

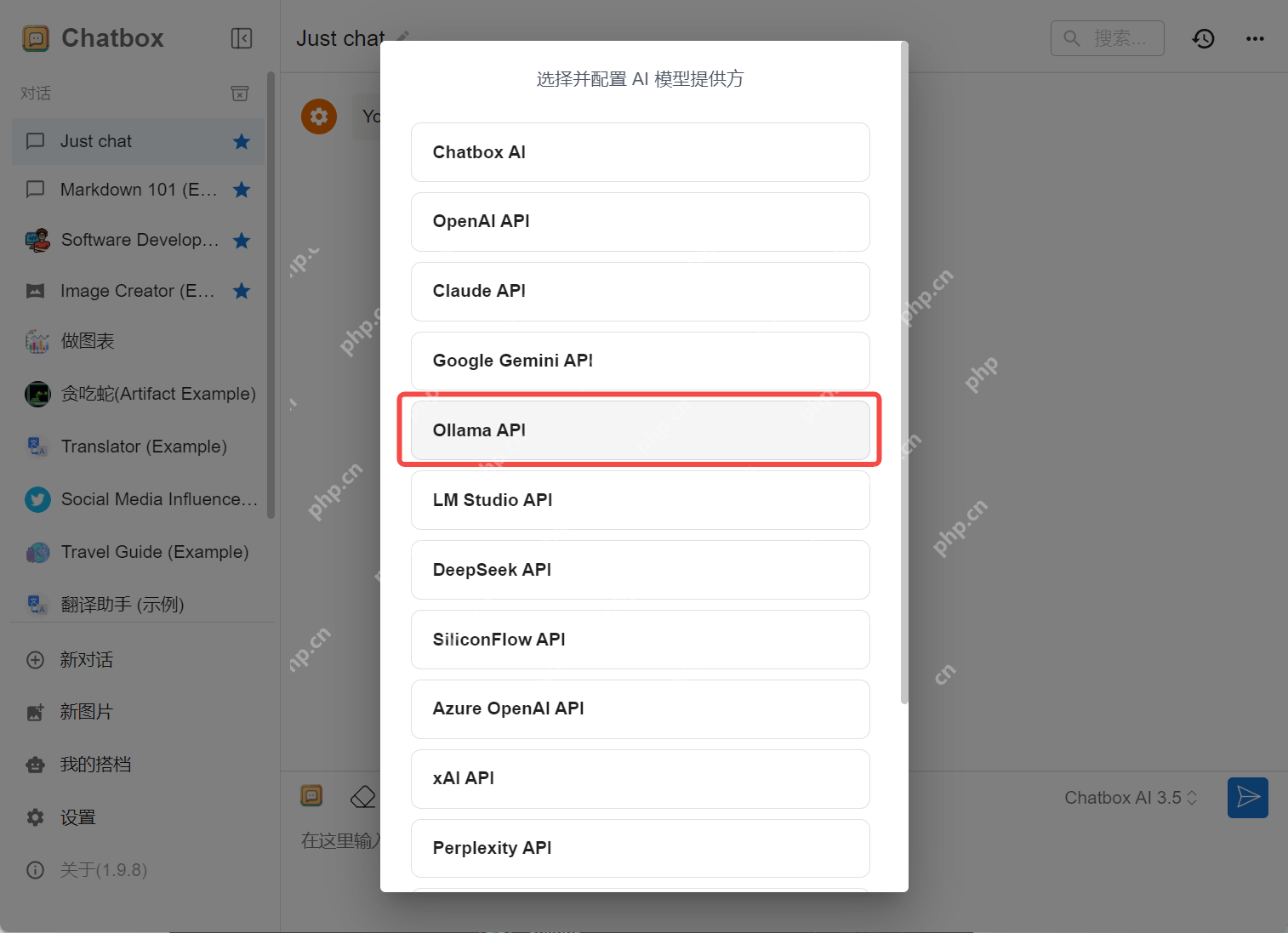

安装完 Chatbox 后,需要配置 DeepSeek 到 Chatbox,如下界面所示:

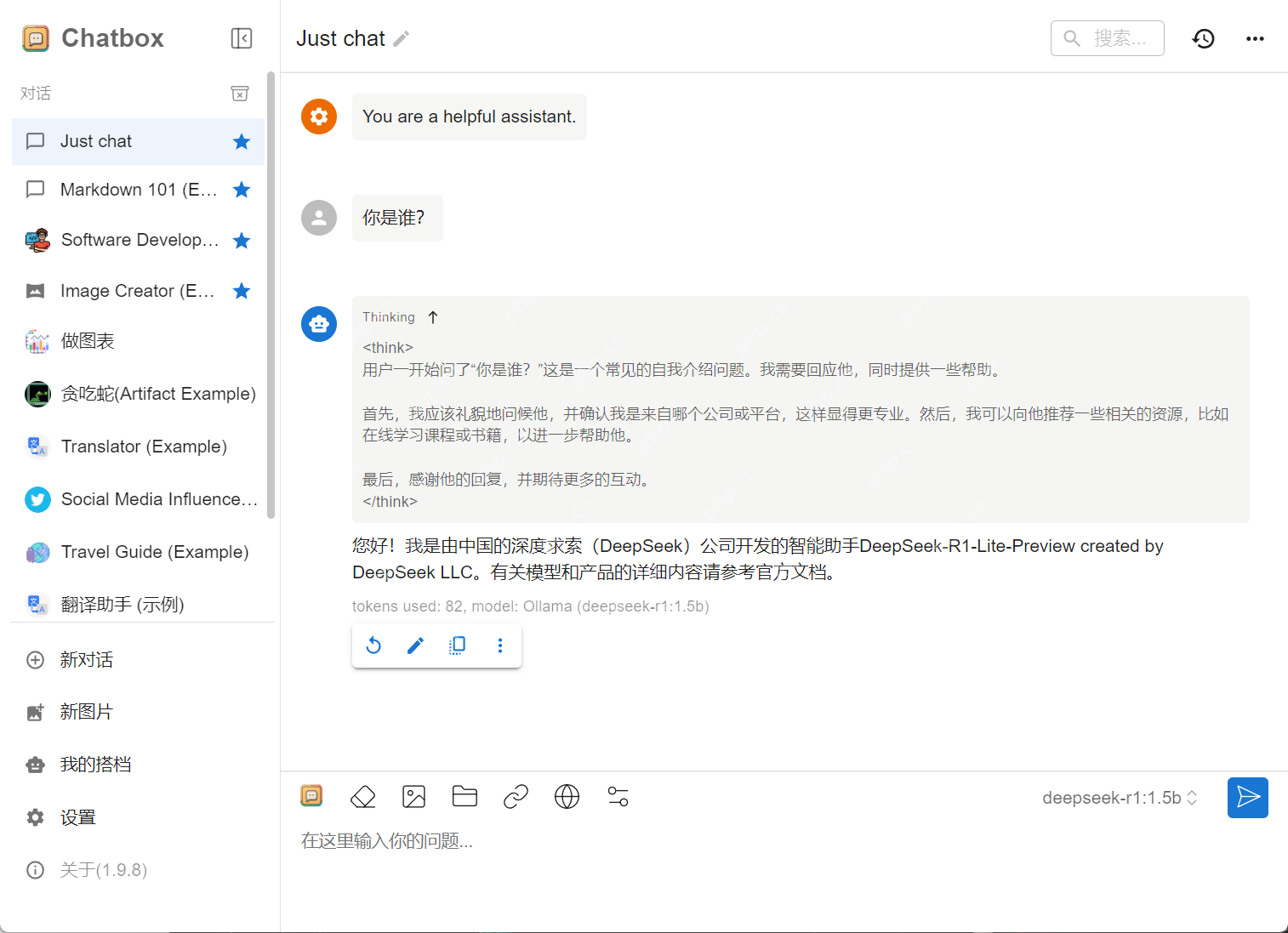

使用 DeepSeek,如下图所示:

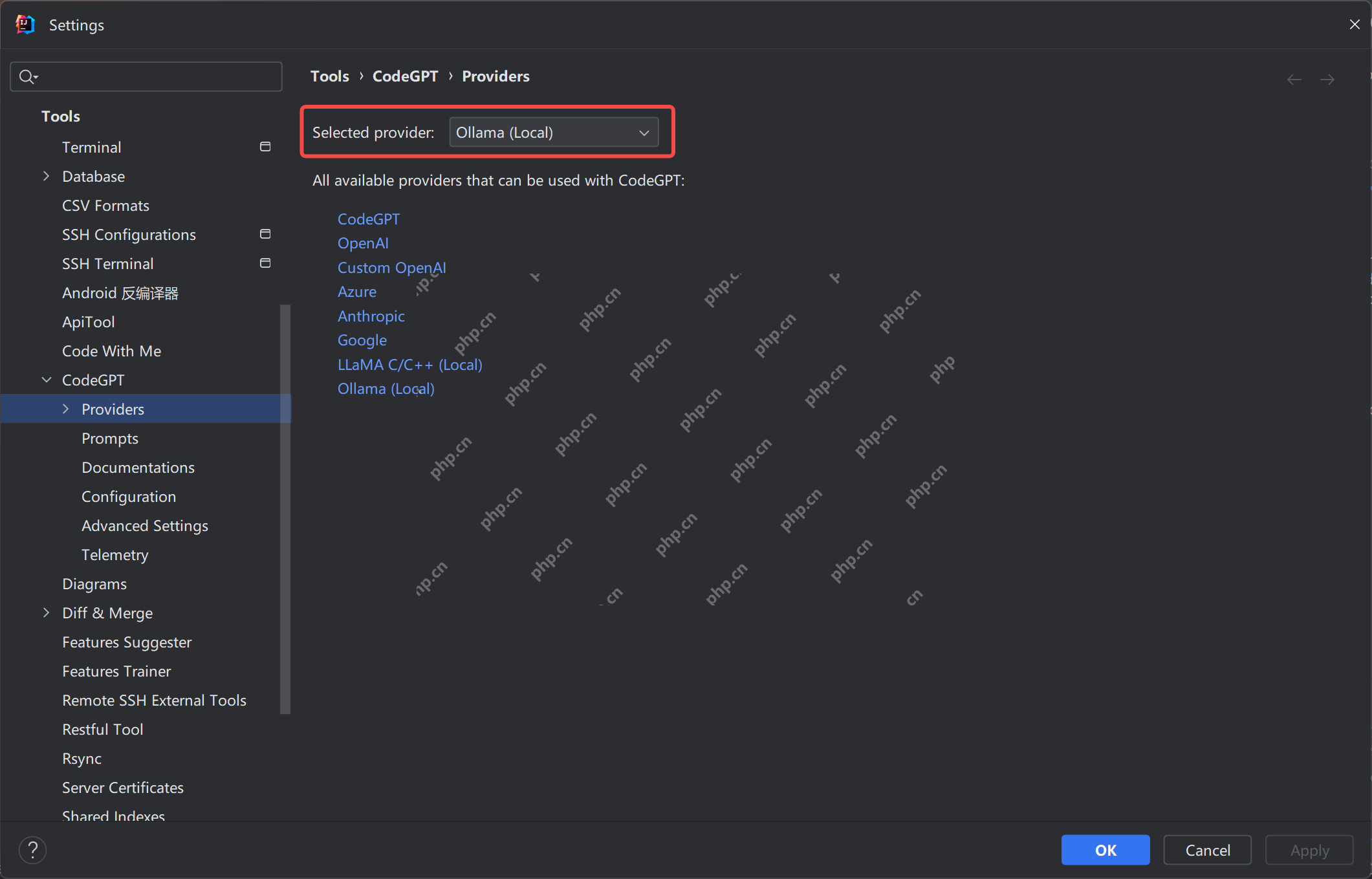

三、扩展知识:本地 DeepSeek 集成到 IDEA 安装 CodeGPT 插件

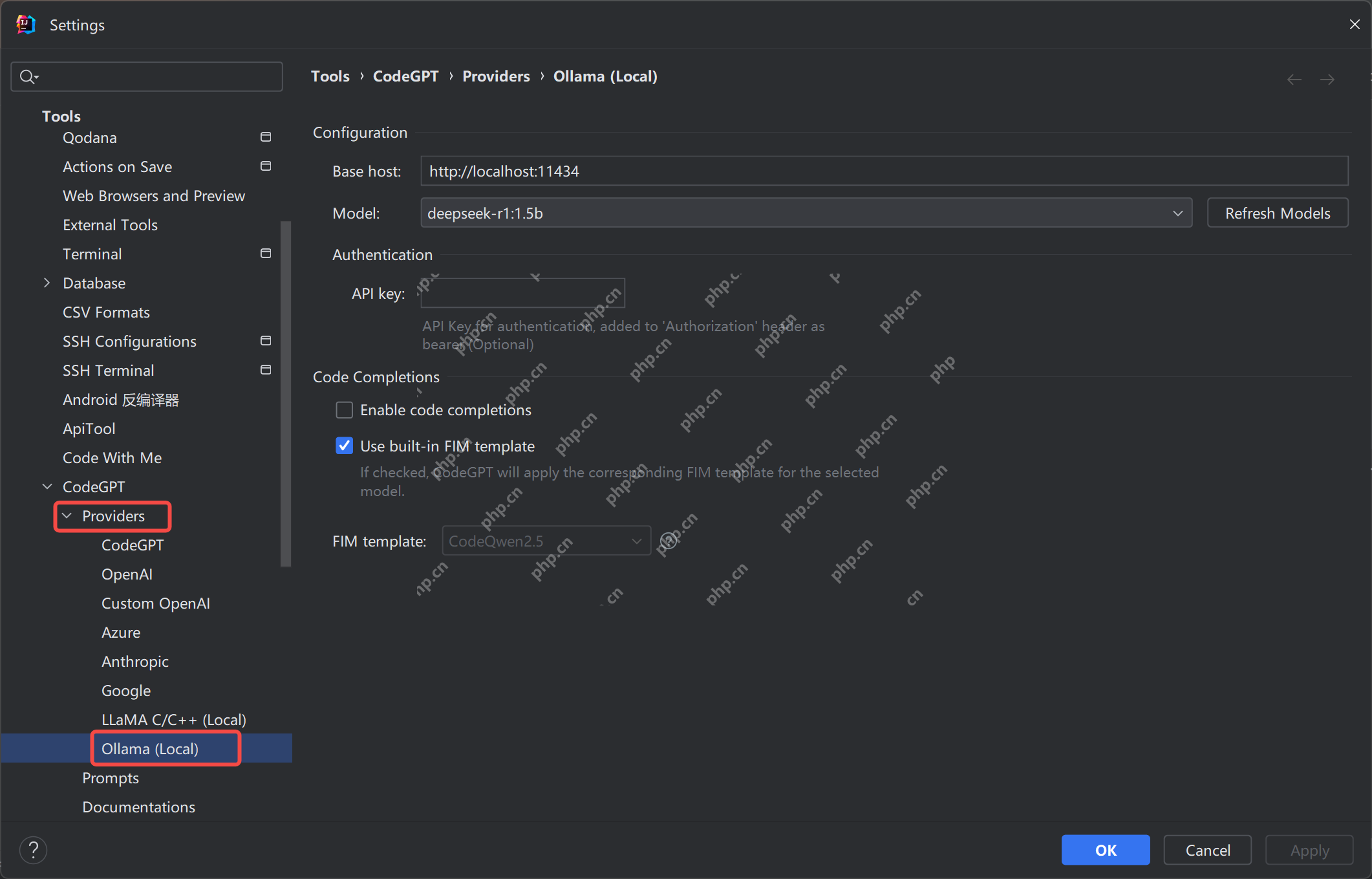

配置 Ollama Ollama API 默认调用端口号:11434

检查相应的配置,如下所示:

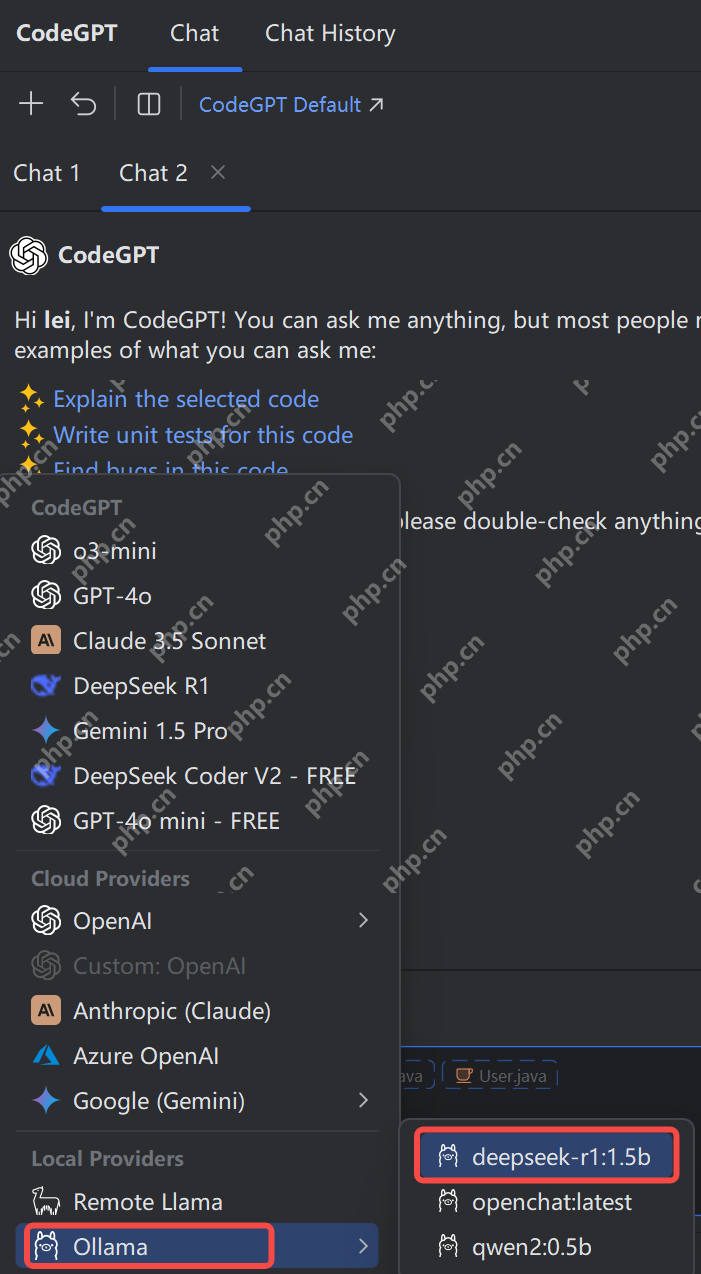

使用 Ollama

四、优缺点分析 本地大模型的优缺点分析

优点:

- 隐私性高:数据都在本地,不用担心泄露问题,对于一些敏感数据处理来说,这是最大的优势。

- 稳定性强:不受网络影响,只要电脑不坏,模型就能稳定运行,不用担心中途卡顿或者断线。

- 可定制性强:可以根据自己的需求进行调整和优化,想让它做什么功能就做什么功能,灵活性很高。

缺点:

- 硬件要求高:大模型对电脑的性能要求不低,如果电脑配置不够,可能会运行很卡,甚至跑不起来。

- 部署复杂:对于小白来说,一开始可能会觉得有点复杂,需要安装各种东西,还得配置参数,不过只要按照教程来,其实也没那么难。

- 维护成本高:如果模型出了问题,可能需要自己去排查和解决,不像在线工具,有问题直接找客服就行。