答案:HTML数据ETL流程包括提取、转换和加载三个阶段。首先通过requests或Selenium获取网页内容,利用BeautifulSoup解析DOM并提取字段;接着使用Pandas清洗数据,标准化格式并处理缺失值;然后将结构化数据写入文件或数据库;最后通过Airflow等工具实现自动化调度与监控,确保流程稳定可靠。

从HTML中提取数据并构建完整的ETL(提取、转换、加载)流程,关键在于将非结构化或半结构化的网页内容转化为结构化数据,并可靠地导入目标系统。以下是实现HTML数据ETL管道的完整流程和实用方法。

1. 数据提取(Extract)

网页数据通常以HTML格式存在,需通过自动化方式获取并解析内容。

获取HTML内容:- 使用Python的

requests库发起HTTP请求获取页面源码。 - 对于JavaScript动态渲染页面,使用

Selenium或Playwright模拟浏览器行为。 - 设置合理的请求头(User-Agent、Referer)避免被反爬虫机制拦截。

- 利用

BeautifulSoup或lxml解析DOM树,定位所需元素。 - 通过CSS选择器或XPath提取标题、价格、描述等字段。

- 处理分页逻辑,遍历所有相关页面确保数据完整性。

示例代码片段:

import requests

from bs4 import BeautifulSoup

url = "https://example.com/products"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

products = []

for item in soup.select('.product-item'):

products.append({

'title': item.select_one('.title').get_text(strip=True),

'price': item.select_one('.price').get_text(strip=True),

'link': item.select_one('a')['href']

})

2. 数据转换(Transform)

原始提取的数据往往包含噪声,需要清洗和标准化。

立即学习“前端免费学习笔记(深入)”;

- 去除HTML标签、空白字符、特殊符号。

- 统一数值格式,如价格转为浮点数,日期转为标准ISO格式。

- 补全缺失值,例如用默认分类或标记“未知”。

- 建立唯一标识符(如URL哈希),防止重复记录。

- 可使用Pandas进行批量处理,提升效率。

示例转换操作:

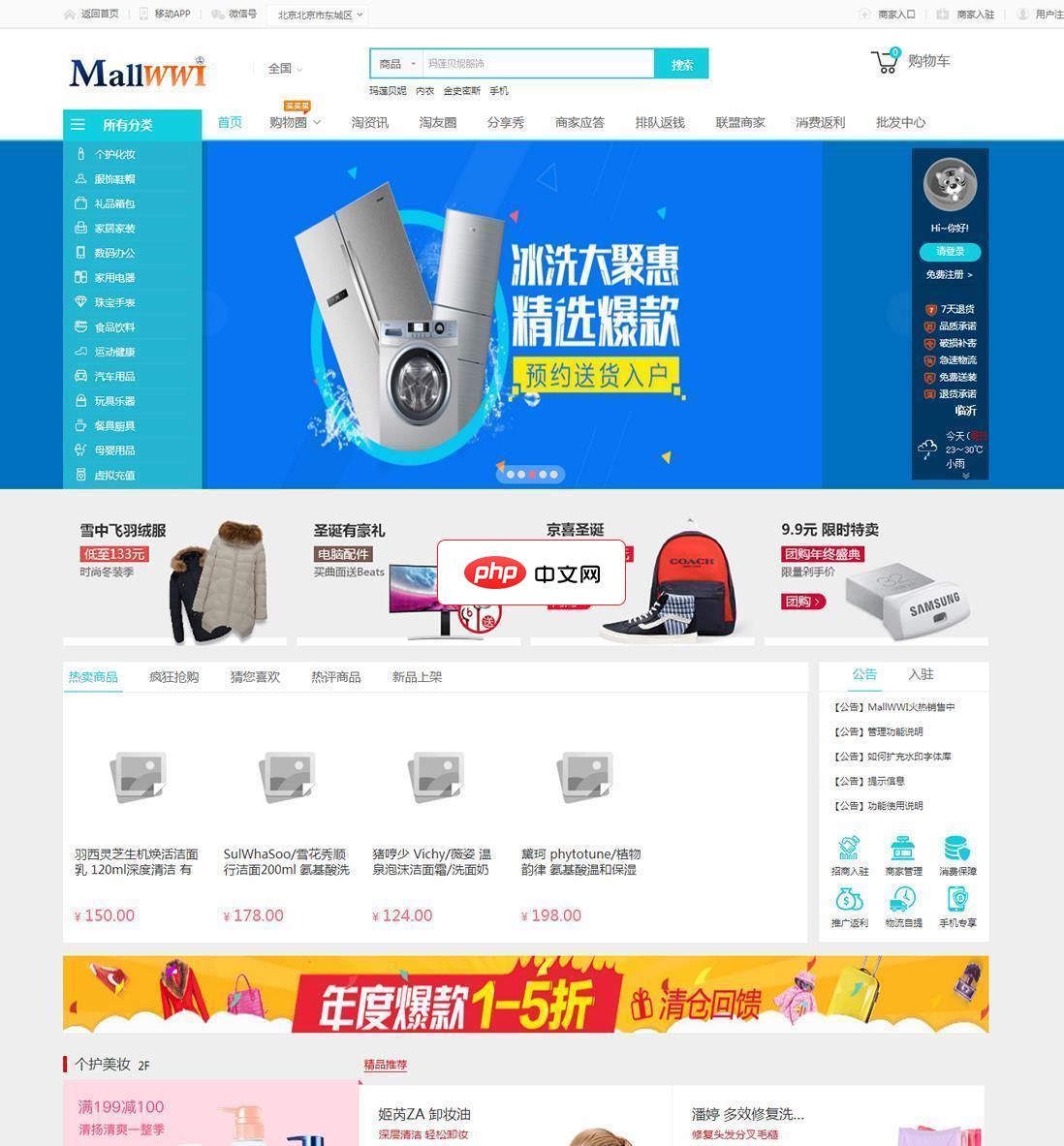

MallWWI新模式返利商城系统基于成熟的飞蛙商城系统程序框架,支持多数据库配合,精美的界面模板,人性化的操作体验,完备的订单流程,丰富的促销形式,适合搭建稳定、高效的电子商务平台。创造性的完美整合B2B\B2C\B2S\C2B\C2C\P2C\O2O\M2C\B2F等模式,引领“互联网+”理念,实现商家联盟体系下的线上线下全新整合销售方式,独创最流行的分红权返利与排队返钱卡功能。安全、稳定、结构

import pandas as pd df = pd.DataFrame(products) df['price'] = df['price'].str.replace(r'[^0-9.]', '', regex=True).astype(float) df['extract_date'] = pd.Timestamp.now()

3. 数据加载(Load)

将处理后的数据写入目标存储系统,供后续分析或应用使用。

- 保存为本地文件:CSV、JSON,适合小规模数据或临时分析。

- 写入数据库:使用SQLAlchemy或psycopg2插入PostgreSQL、MySQL等关系型数据库。

- 对接数据仓库:通过API或中间件导入Snowflake、BigQuery等平台。

- 支持增量更新:根据时间戳或ID判断是否为新数据,避免重复加载。

数据库写入示例:

from sqlalchemy import create_engine

engine = create_engine('postgresql://user:pass@localhost/dbname')

df.to_sql('products', engine, if_exists='append', index=False)

4. 管道自动化与监控

一个健壮的ETL流程应具备可调度性和可观测性。

- 使用Airflow或Prefect编排任务,设定定时执行策略(如每天凌晨运行)。

- 记录日志信息:成功条数、异常页面、网络错误等。

- 添加重试机制应对临时网络故障。

- 设置告警通知,当数据量突降或解析失败时及时响应。

- 定期评估网站结构变化,维护选择器稳定性。

基本上就这些。一套稳定的HTML ETL流程,核心是灵活提取、严谨清洗、可靠存储,并持续监控。只要结构清晰,即使网页稍有变动也能快速调整适应。