multiprocessing子进程不继承主线程全局变量修改,因其通过fork或spawn新建独立内存空间;Pool的maxtasksperchild用于定期重启worker防内存泄漏;Queue传大对象慢因序列化开销大,应优先用shared_memory;Windows下不加if name == "__main__":会导致子进程重复执行顶层代码而崩溃。

为什么 multiprocessing 启动的子进程不继承主线程的全局变量修改?

因为子进程是通过 fork(Unix/Linux/macOS)或 spawn(Windows/部分 macOS 配置)方式全新创建的,内存空间独立。主线程对全局变量(如 config = {"debug": True})的运行时修改,不会自动同步到子进程中。

常见错误现象:在主进程中改了 LOG_LEVEL,子进程里打印仍是默认值;或用 global 修饰的变量在子进程里为空。

- Unix 系统下若用

fork启动方式,子进程会复制父进程的内存快照,但后续修改互不影响 - Windows 必须用

spawn,每次启动子进程都会重新导入模块、执行顶层代码,所以连初始值都要靠模块重载保证一致 - 跨平台安全做法:把配置显式传给子进程,例如通过

Process(target=worker, args=(config,))或使用multiprocessing.Manager().dict()

multiprocessing.Pool 的 maxtasksperchild 有什么实际作用?

它控制每个子进程最多处理多少个任务后自动退出并被新进程替换。不是“限制并发数”,而是用于缓解内存泄漏或状态累积问题。

使用场景:长期运行的 worker 处理大量任务,且内部使用了无法自动释放的资源(如未关闭的文件句柄、缓存不断增长的字典、第三方 C 库的静态状态)。

立即学习“Python免费学习笔记(深入)”;

- 设为

None(默认):子进程永生,风险是内存缓慢上涨 - 设为

100:每处理完 100 个任务就重启该 worker,开销小但能重置内存和状态 - 注意:重启有轻微调度成本,别设成

1;也别依赖子进程间共享可变状态,因为它随时可能被换掉

为什么用 multiprocessing.Queue 传大对象比 pipe 更慢还容易卡住?

因为 Queue 底层基于 Pipe + 单独的监控线程 + 序列化(pickle),而大对象序列化耗时高,且 Queue 有内置缓冲区大小限制(默认无限,但受系统 pipe buffer 和内存影响)。

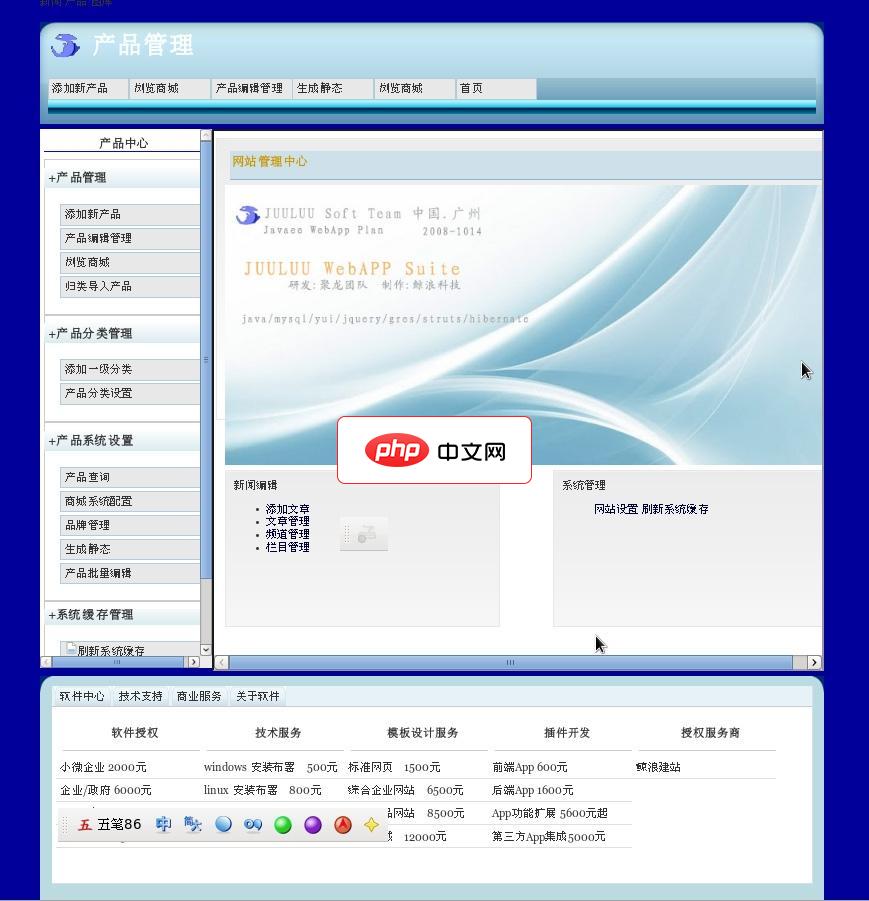

KgShop,是国内一款快速/稳定/安全的开源电子商城系统,采用linux,mysql,srutsEX,hibernate,ejb3等技术,Kghop第一版诞生于2010年,经过多年开发,Kgshop系统已拥有快速、稳定、支持大量并发访问等软件特性,是10万人在线的JAVA商城优秀解决方案。KgShop拥有良好的模板机制,易于进行二次开发。Kgshop每一行代码都经过严谨的测试,汇聚大批工程师多年

典型错误现象:传一个 500MB 的 numpy.ndarray,主进程卡在 q.put(arr),子进程迟迟收不到;或出现 OSError: [Errno 32] Broken pipe。

- 优先考虑

multiprocessing.shared_memory(Python 3.8+)共享内存块,避免拷贝和序列化 - 若必须用

Queue,提前调用arr = np.ascontiguousarray(arr)加速 pickle,或改用joblib.dump/load分块序列化 -

Pipe更轻量,适合点对点、少量高频通信,但它不支持多生产者/消费者,也不能用在Pool场景中

Windows 下 if __name__ == "__main__" 不加会导致什么?

子进程启动时会重新执行整个脚本顶层代码,包括再次创建 Pool、再次导入模块、甚至重复初始化数据库连接——最终引发 RuntimeError: An attempt has been made to start a new process before the current process has finished its bootstrapping phase。

这不是风格建议,而是 Windows 的 spawn 启动机制强制要求。

- 所有使用

multiprocessing的脚本,在 Windows 或跨平台分发时,必须把Pool/Process创建逻辑包进if __name__ == "__main__":块 - PyInstaller 打包后也遵循同样规则,漏写会导致生成的 exe 在双击运行时报错退出

- macOS/Linux 虽可用

fork暂时绕过,但一旦切换启动方法(如设置mp.set_start_method("spawn")),同样崩溃

多进程真正难的不是启动几个子进程,而是数据怎么传、状态怎么管、异常怎么捕获、资源怎么回收。尤其当逻辑从单进程迁移到多进程时,看似只改两行代码,实则每处变量访问都得重新评估作用域和生命周期。