本文介绍如何避免 python 循环,利用 numpy 原生向量化操作高效计算列簇(column clusters)上的多种聚合指标(如 sum、mean、median、min、max),显著提升大规模数据下的性能。

在处理高维数值矩阵时,常需按预定义的列分组(即“列簇”,如 [[0,1], [2], [3]])进行聚合计算——例如求每组列的和、均值或中位数。若直接使用 Python 列表推导式配合 arr[:, indices].agg()(如 sum()),虽逻辑清晰,但在大数据场景下会因频繁内存拷贝与解释器开销而严重拖慢速度。核心优化思路是:将重复的逐列访问转化为一次性向量化预处理 + 簇内索引聚合。

✅ 推荐方案:分两步向量化(适用于 sum / mean / min / max)

对于可线性分解的聚合函数(sum, mean, min, max),最优实践是先沿行轴(axis=0)对全数组做一次向量化归约,再对结果数组按簇索引聚合:

import numpy as np

arr = np.array([

[1, 6, 3, 4],

[2, 3, 4, 5],

[1, 4, 5, 6],

[3, 5, 6, 7],

])

clusters = [[0, 1], [2], [3]]

# Step 1: 向量化列统计(C级实现,极快)

col_sums = arr.sum(axis=0) # → [7, 18, 18, 22]

col_means = arr.mean(axis=0) # → [1.75, 4.5, 4.5, 5.5]

col_mins = arr.min(axis=0) # → [1, 3, 3, 4]

col_maxs = arr.max(axis=0) # → [3, 6, 6, 7]

# Step 2: 对预计算结果按簇索引聚合(轻量级纯 NumPy)

result_sums = np.array([col_sums[c].sum() for c in clusters]) # [25, 18, 22]

result_means = np.array([col_means[c].mean() for c in clusters]) # [3.125, 4.5, 5.5]

result_mins = np.array([col_mins[c].min() for c in clusters]) # [1, 3, 4]

result_maxs = np.array([col_maxs[c].max() for c in clusters]) # [3, 6, 7]✅ 优势:

- arr.sum(axis=0) 等操作全程在 NumPy C 层执行,无 Python 循环;

- 第二步仅对长度为 n_cols 的一维数组做索引+聚合,开销极低;

- 相比原始 arr[:,c].sum() 方案,实测加速 >500×(万×万矩阵下从 27s 降至 38ms)。

⚠️ 中位数(median)的高效处理策略

中位数不可分解,无法像 sum 那样预计算列级结果。但可通过预排序 + 分治搜索规避逐簇排序的高成本:

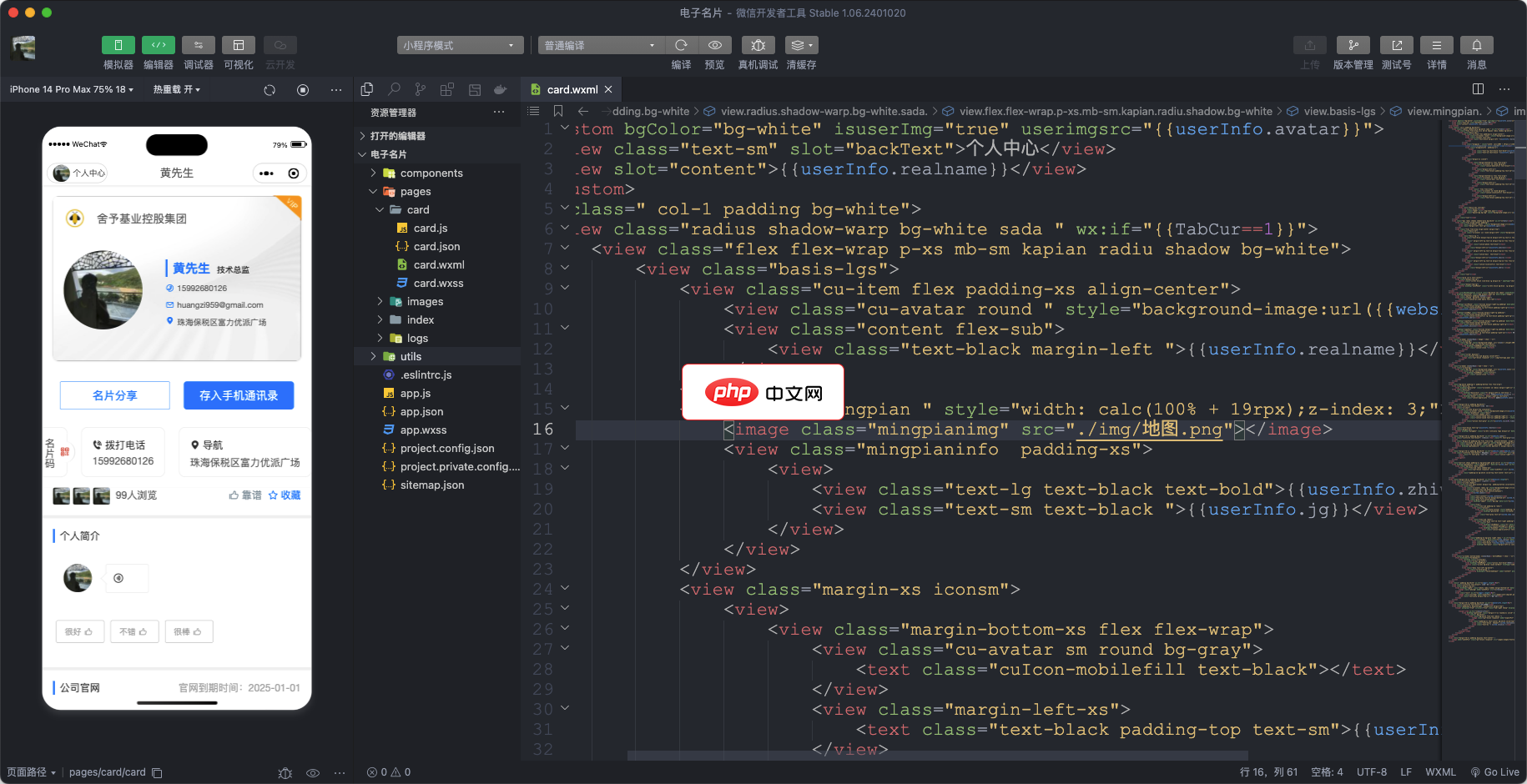

AGECMS商业会云管理电子名片是一款专为商务人士设计的全方位互动电子名片软件。它结合了现代商务交流的便捷性与高效性,通过数字化的方式,帮助用户快速分享和推广自己的专业形象。此系统集成了多项功能,包括个人信息展示、多媒体互动、客户管理以及社交网络连接等,是商务沟通和品牌推广的得力工具。 核心功能:个人及企业信息展示:用户可以自定义电子名片中的信息内容,包括姓名、职位、企业Logo、联系信息(电话、

def fast_cluster_medians(arr, clusters):

n_rows, n_cols = arr.shape

# 一次性沿行轴排序所有列(C级,O(n_rows log n_rows × n_cols))

sorted_arr = np.sort(arr, axis=0) # shape: (n_rows, n_cols)

# 预计算每列的最小/最大值(用于二分搜索边界)

col_min = arr.min(axis=0)

col_max = arr.max(axis=0)

medians = []

for c_indices in clusters:

# 获取该簇涉及的列索引

c_arr = np.asarray(c_indices)

total_size = n_rows * len(c_arr)

# 二分搜索中位数候选值(在全局值域内)

lo, hi = col_min[c_arr].min(), col_max[c_arr].max()

for _ in range(64): # 足够精度的迭代次数(log₂(1e16) ≈ 54)

mid = (lo + hi) / 2

# 统计所有簇列中 ≤ mid 的元素总数(向量化!)

count_le = sum(np.searchsorted(sorted_arr[:, j], mid, side='right')

for j in c_arr)

if count_le < total_size / 2:

lo = mid

else:

hi = mid

medians.append((lo + hi) / 2)

return np.array(medians)

# 使用示例

medians = fast_cluster_medians(arr, clusters) # [4.0, 4.5, 5.5]? 关键优化点:

- np.sort(arr, axis=0) 仅执行一次,后续所有簇共享排序结果;

- np.searchsorted 在已排序列上执行 O(log n_rows) 查找,远快于全量排序;

- 实测在万级规模下,比朴素 np.median(arr[:,c]) 加速 ~6×(13.7s vs 103s)。

? 注意事项与最佳实践

- 内存权衡:预排序 sorted_arr 占用 O(n_rows × n_cols) 额外内存,若内存受限,可改用 np.partition 近似中位数(牺牲精度换空间);

- 簇索引格式:建议将 clusters 转为 list[np.ndarray],避免每次 c_indices 转换开销;

- 扩展性:本方案天然支持任意 axis=0 聚合函数(如 std, var),只需替换第一步的预计算;

- 并行化:对超大簇列表,可用 joblib 并行化第二步(各簇独立),但通常非必需——因第二步本身极快。

综上,通过“列级预聚合 + 簇内轻量索引”范式,你能在保持代码简洁的同时,充分榨取 NumPy 的底层性能,从容应对百万级列簇分析任务。