本文介绍了C++预测代码的编译及封装为dll的流程。编译需准备Cmake、VS2019等工具和相关依赖库,经配置环境变量、Cmake编译生成sln,再用VS生成exe,最后通过cmd预测。封装dll需修改CMakeLists.txt和main.cc,重新生成后可被Python和C#调用。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

一、如何进行C++预测代码的编译(生成.sln解决方案,exe方案)

1.1准备

- 工具:Cmake,VS2019社区版, Git(三个安装包已载入到项目)

- 依赖库:

- Opencv (3.4.6版,已载入到项目 opencv-3.4.6-vc14_vc15.exe,解压时目录要和预测库放在一个目录下)

- Paddle预测库(Windows cuda10 paddle2.0版,paddle_inference_install_dir.zip,需要自行下载)

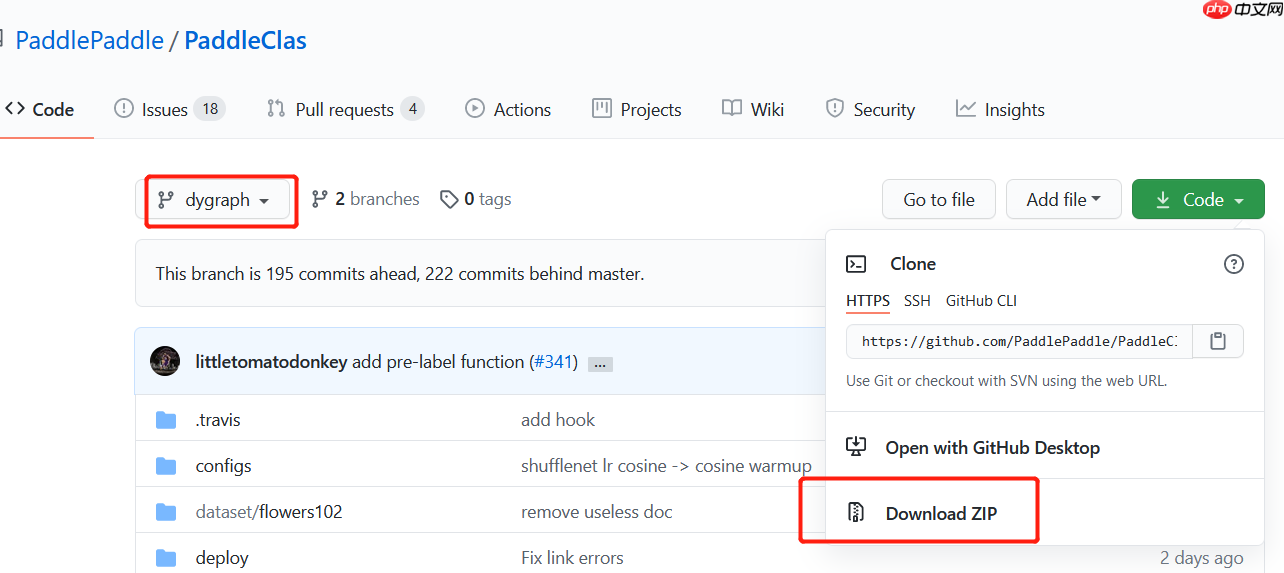

- PaddleClas:(release2.0版)

Aistudio截图:

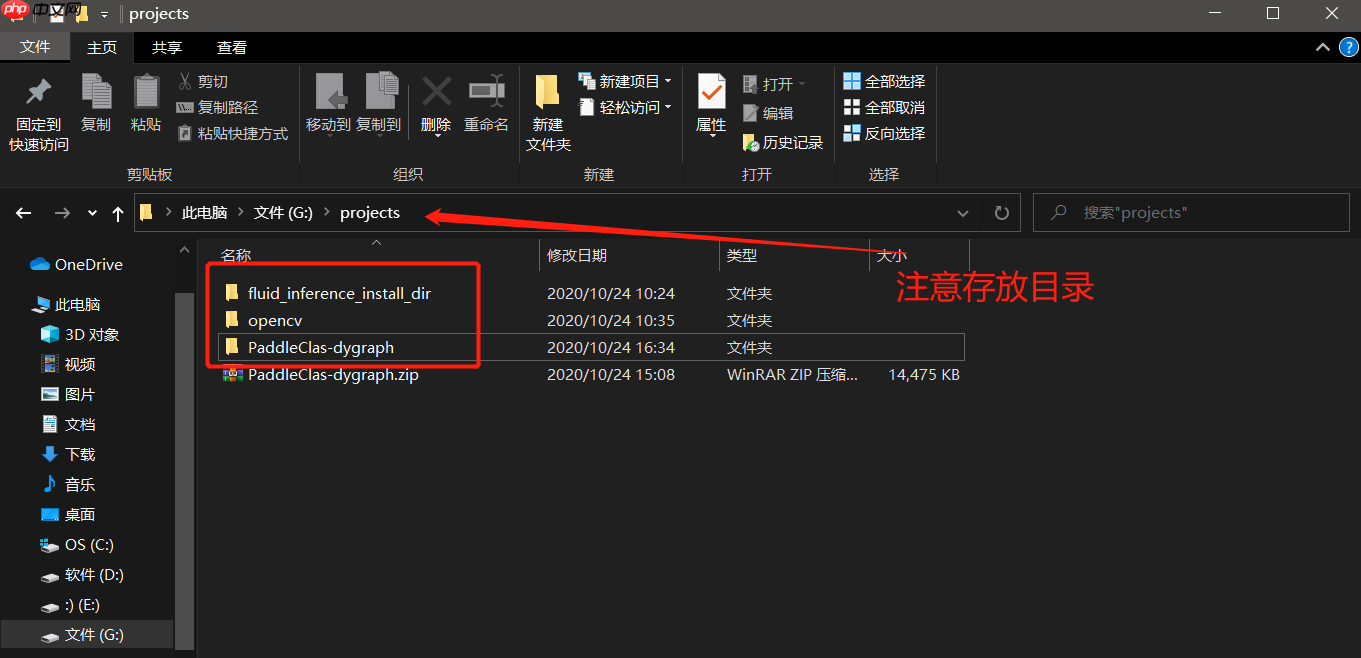

1.2 将依赖库和预测代码存放在一个目录下

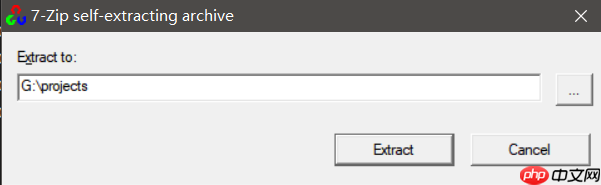

- Opencv打开后会显示解压路径,选择或者新建一个文件夹(之后的预测库和Clas都会放在该目录下)

1.3 将opencv添加到环境变量

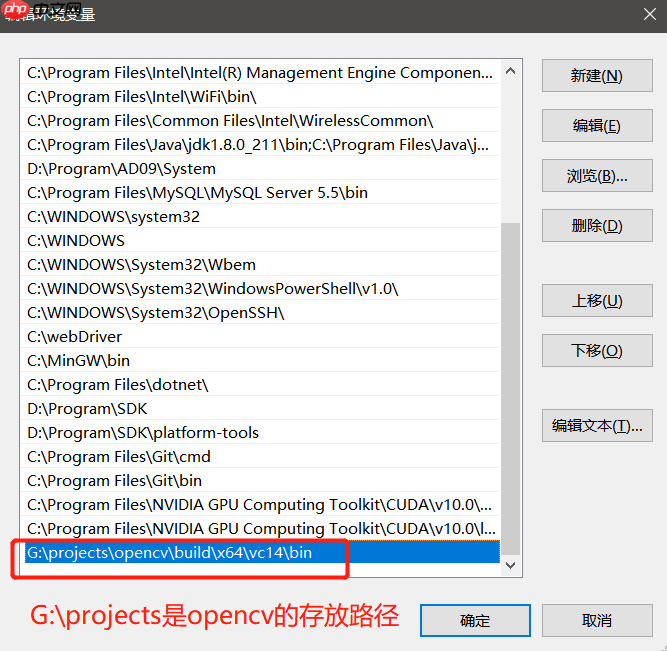

- 打开opencv目录,把opencv路径下的的opencv\build\x64\vc14\bin 路径添加到path环境变量中:

- 环境变量打开方式:右键计算机图标->高级系统设置->高级->环境变量

- 编辑系统变量 path:添加变量值“G:\projects\opencv\build\x64\vc14\bin”,确定

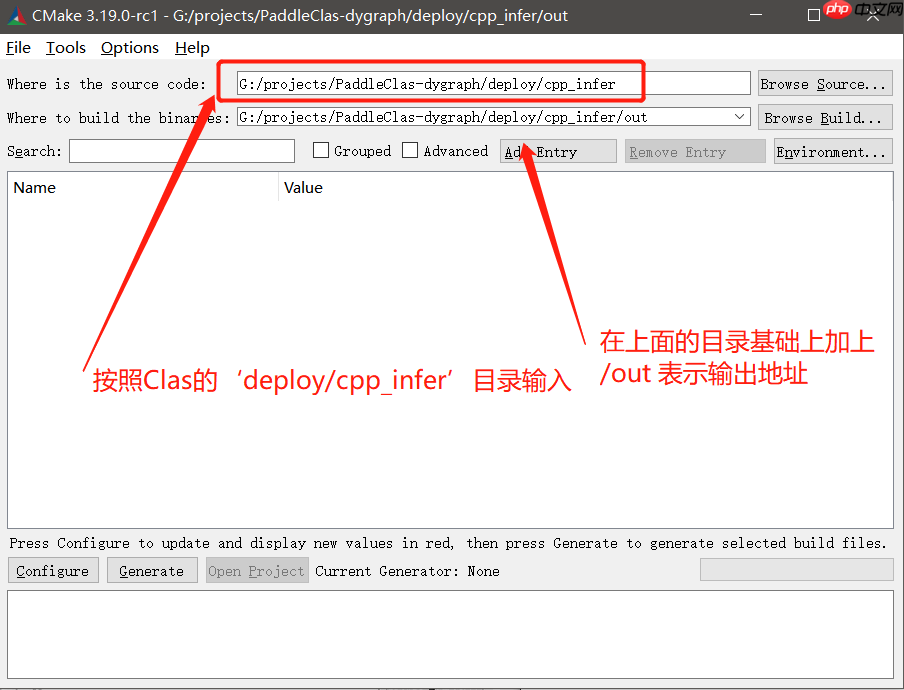

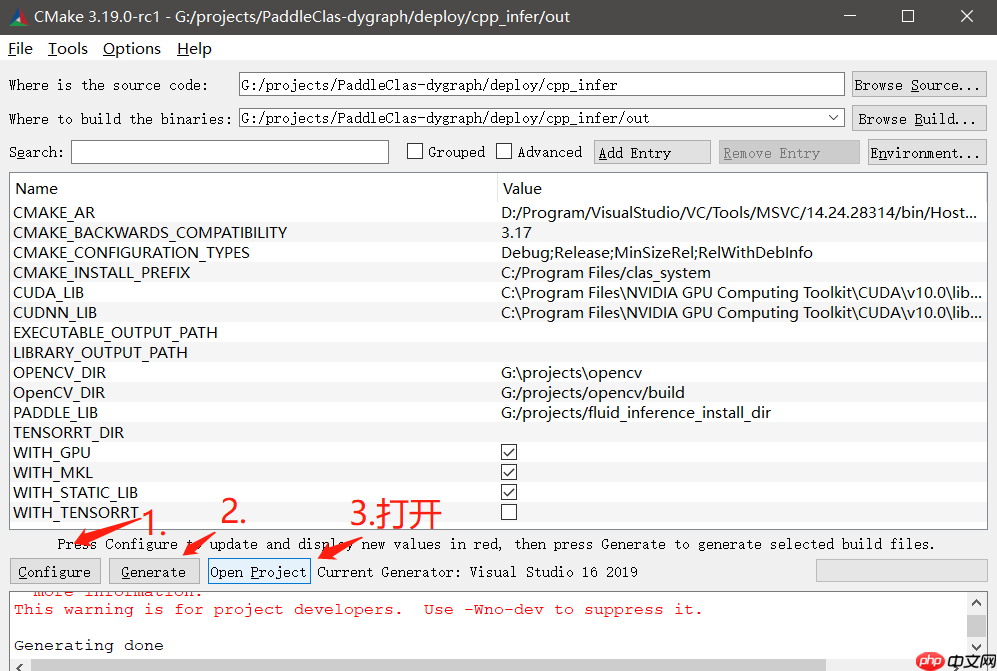

1.4 利用Cmake软件进行编译

在Windows搜索栏输入Cmake打开Cmake gui(如果没有请重新安装下,安装包见1.1章节)

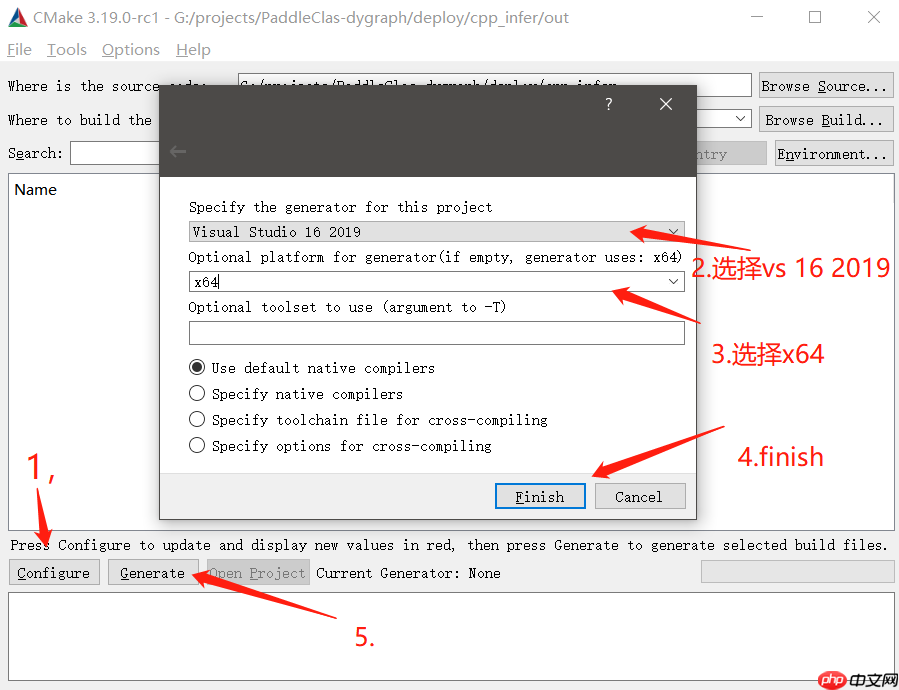

点击configure,选择vs2019 X64选项后,点击Generate

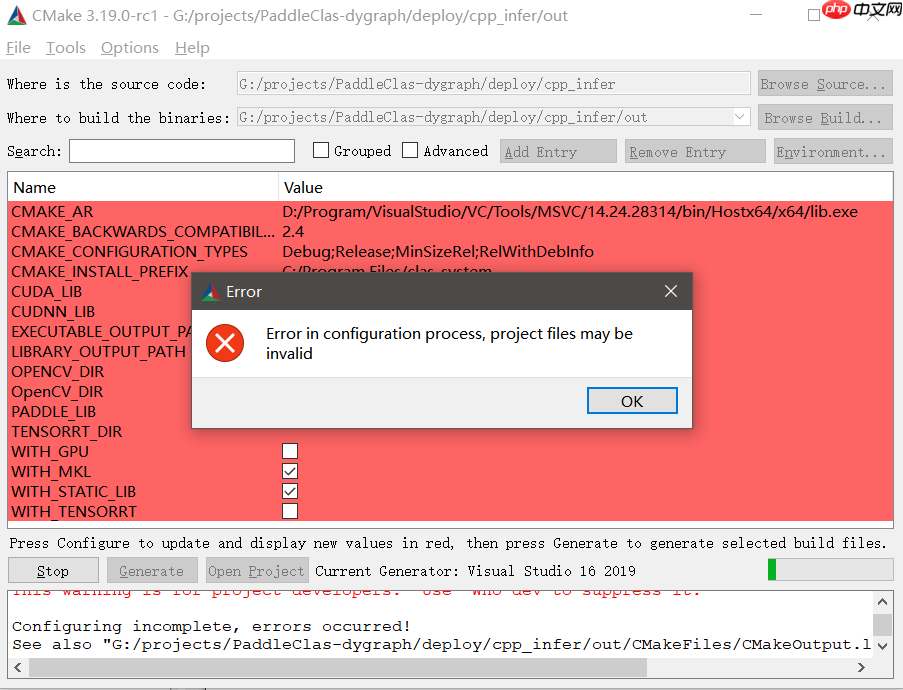

然后会发现报错:如下:

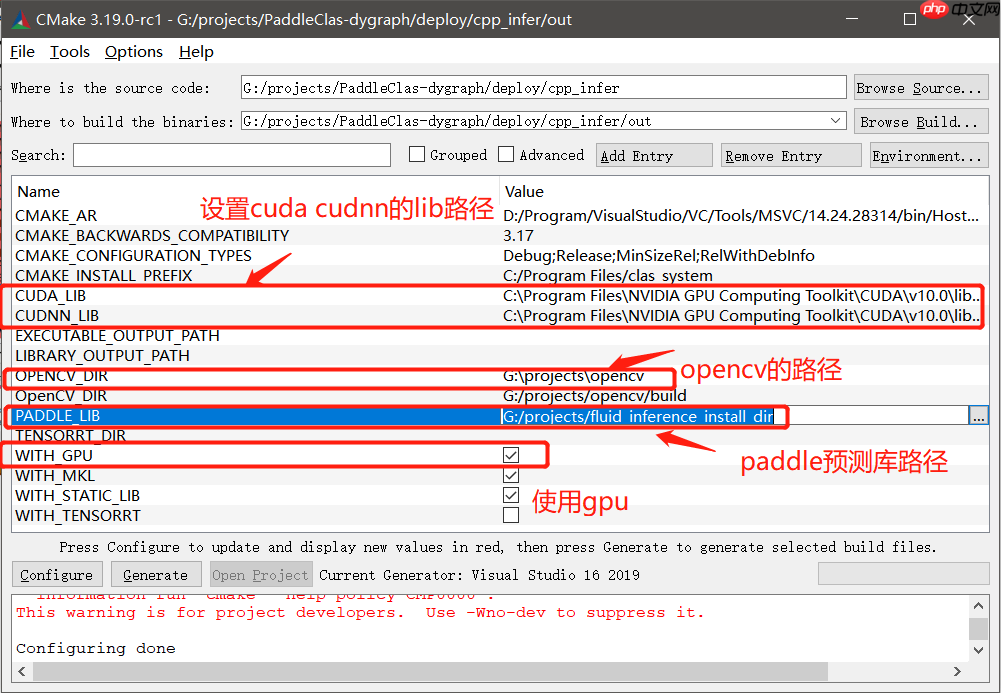

根据报错进行修改,主要修改cuda_lib、cudnn_lib、opencv、paddle_dir路径(双击修改)

CUDA_LIB: C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.0\lib\x64 CUDNN_LIB: C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.0\lib\x64 OPENCV:G:\projects\opencv PADDLE_DIR:G:\projects\paddle_inference_install_dir

修改完成,再次点击 Generate,表示生成sln解决方案。

----------------------------------------------------------------------------------------------------------------------------------------------------------------

如果出现错误,请检查各路径是否正确,以及预测库对应版本是否正确

----------------------------------------------------------------------------------------------------------------------------------------------------------------

1.5 生成exe文件

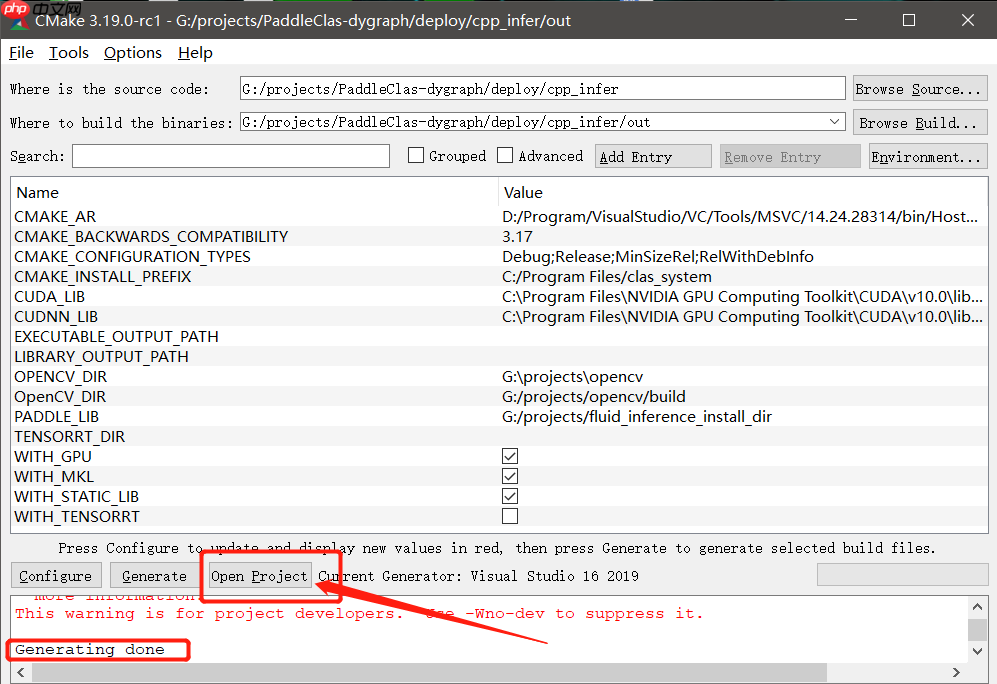

当显示Generating done 后点击open Project(已经安装好vs2019)打开sln解决方案

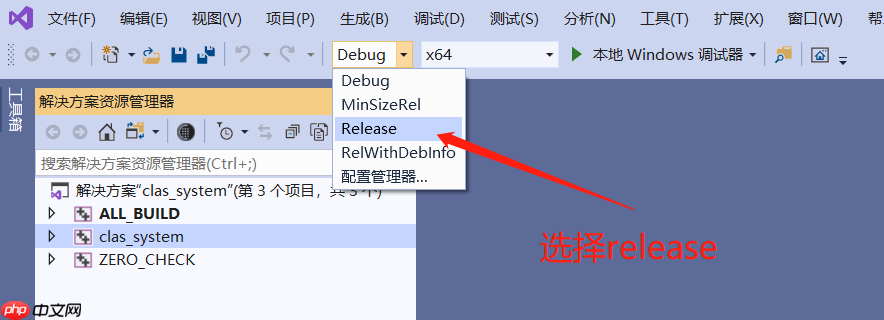

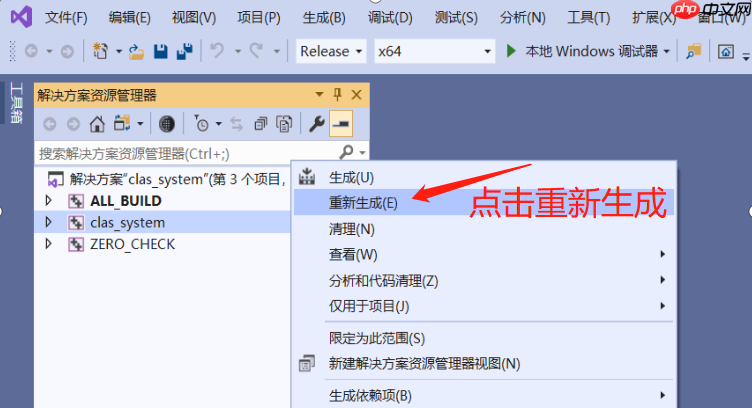

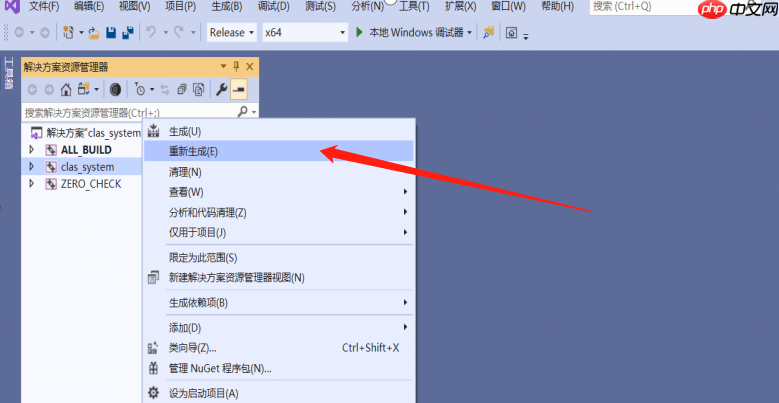

打开后需要重新生成解决方案,同时把debug改为release:

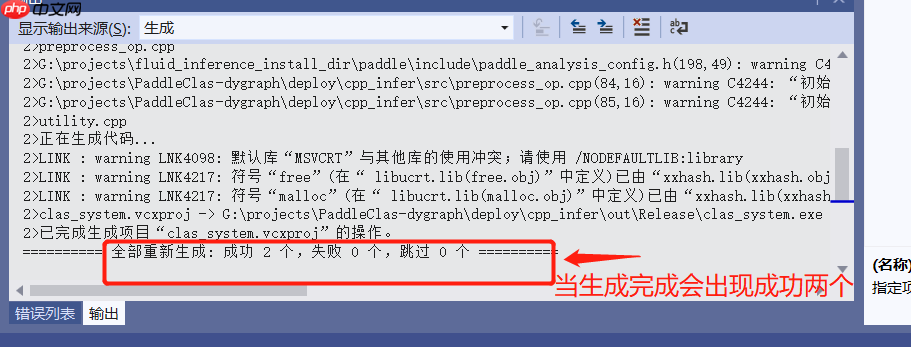

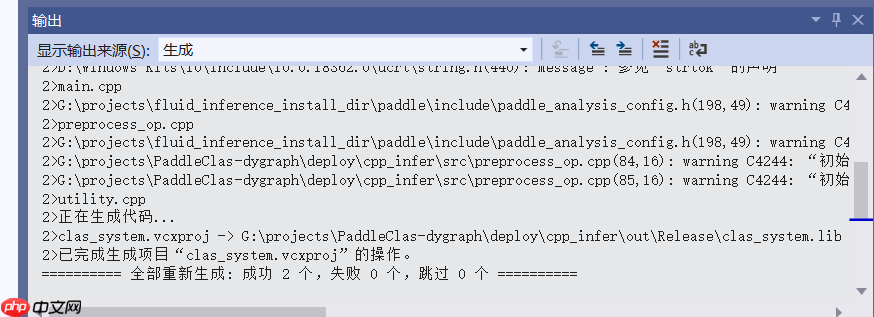

生成可能会有段时间,稍等一会,有如下显示表示生成完成

1.6 使用exe文件预测

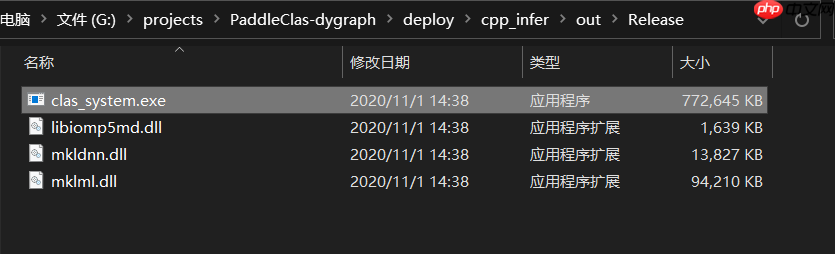

当我们使用vs重新生成完成后,会发现 out目录下面有一个release文件文件夹,该文件夹下是我们刚才生成的 clas_system.exe 文件:

接下来,我们使用该exe来预测图片:

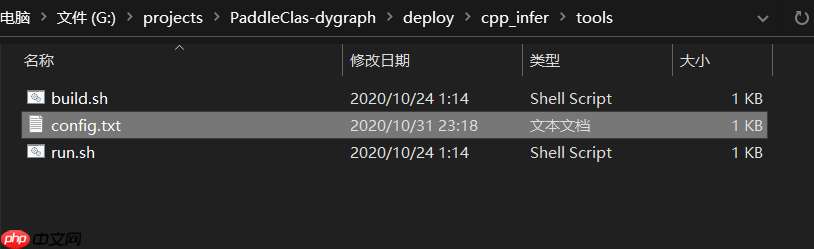

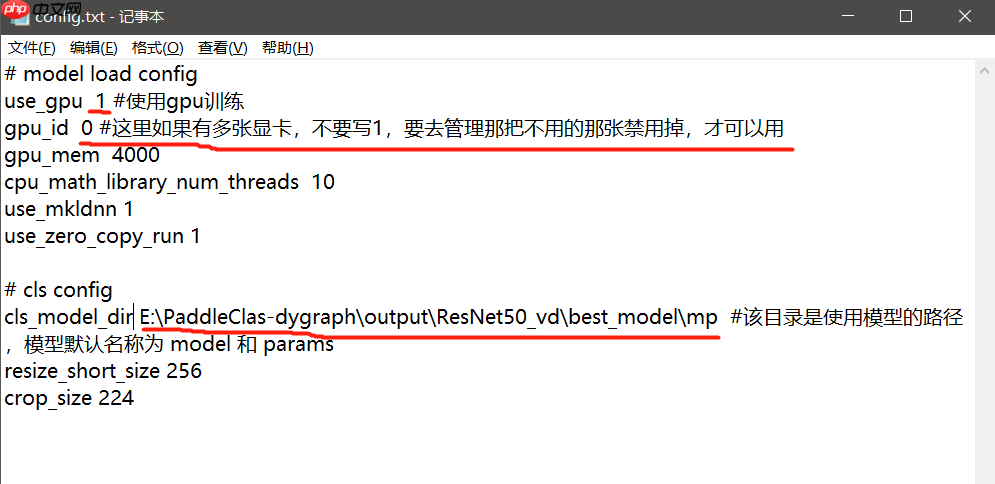

预测前需要准备配置文件 :配置文件为cpp_infer\tools目录下 config.txt

记事本打开该文件,并作如下修改:

- use_gpu 1 表示使用gpu预测

- gpu_id 0 这里如果电脑有多张卡(核显和集显),需要去设备管理器禁用掉不用的那张显卡,不能写1 ,因为Windows不支持多卡训练,默认为0

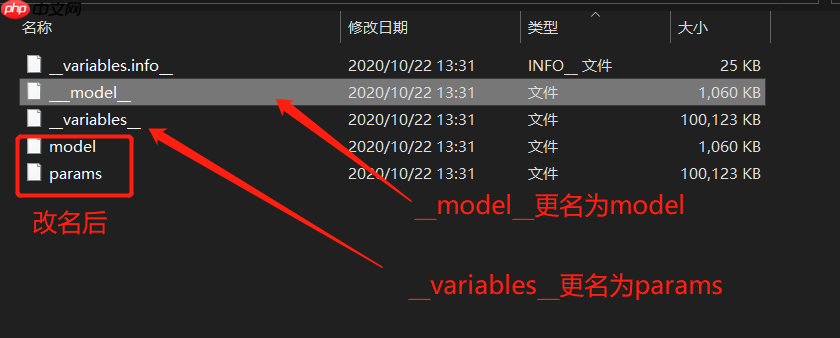

- cls_model_dir 使用预测模型的路径,根据之前自己训练的模型,转换成inference模型后的路径(如果没有训练,请查看链接4.2章节,因为版本更新,需要把__model__和__variables__分别改名为model和params)

#### **例:如下**

以上更改完成后使用cmd来预测一下(此为示例,具体目录根据自己路径来):

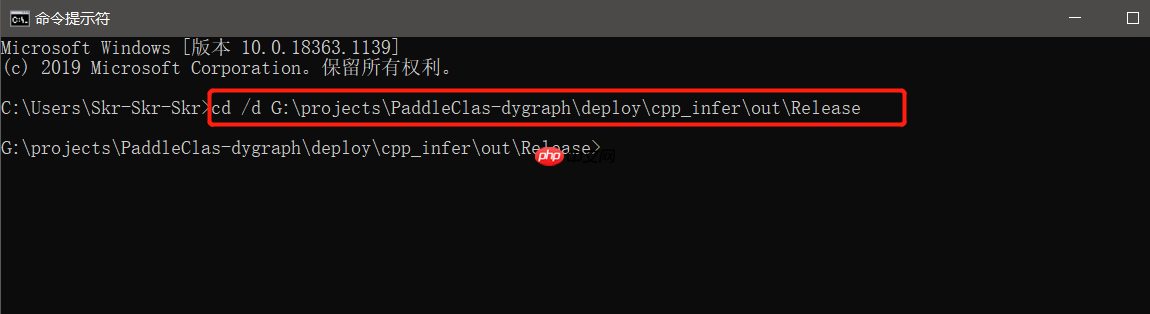

cd到release目录:

使用clas_system.exe 配置文件路径 图片路径 进行预测:

.\clas_system.exe ..\..\tools\config.txt ..\..\..\..\dataset\flowers102\jpg\image_00001.jpg

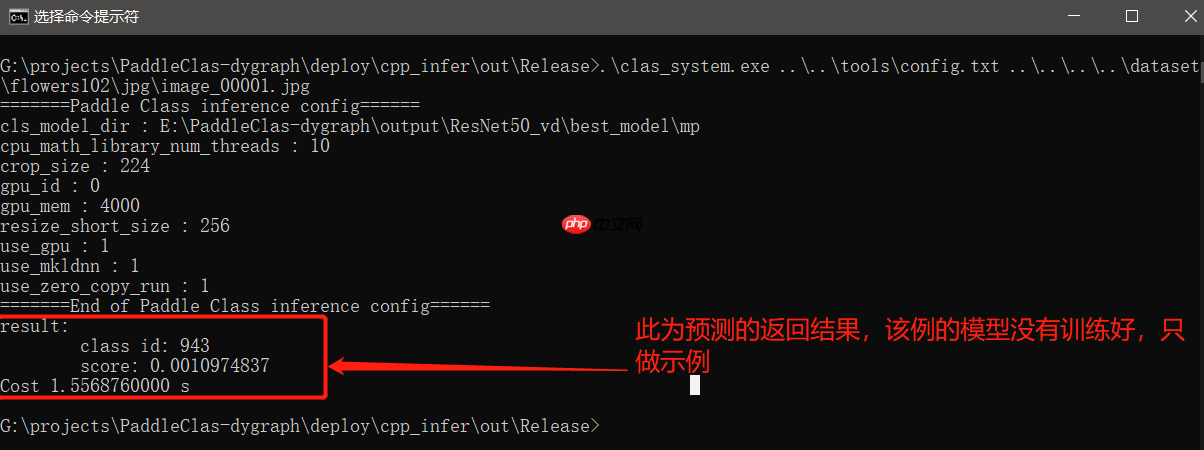

预测结果如下:

注:预测的图片为dataset/flowers102目录下图片,如果没有下载,请查看链接2.1章节

以上我们完成了使用exe文件的预测流程

二、如何将C++预测代码封装成一个dll、

上面章节我们完成了exe文件的预测流程,但是如果我们打算通过别的程序来预测呢!这里我们将完成dll的封装

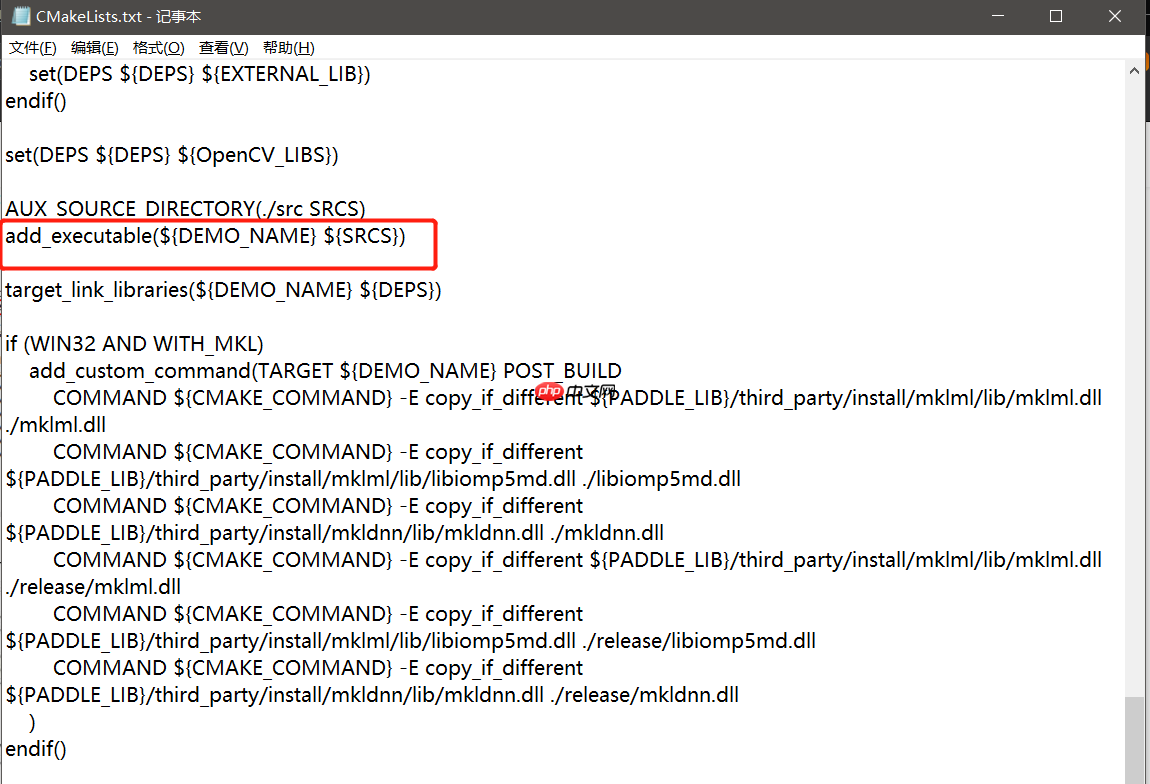

2.1 修改CMakeLists.txt

该文件在deploy/cpp_infer目录下

修改该文件的倒数第20行

add_executable(${DEMO_NAME} ${SRCS})

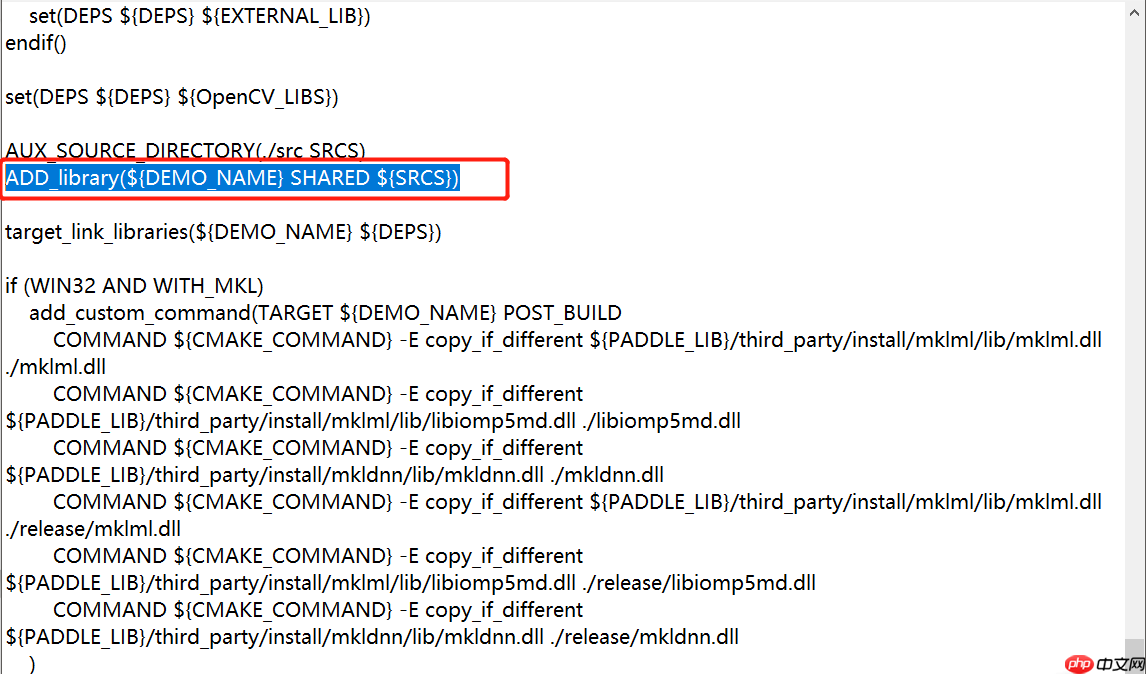

改为ADD_library(${DEMO_NAME} SHARED ${SRCS})

改成如下字样:

2.2 按照上文1.4章节继续重新cmake一次

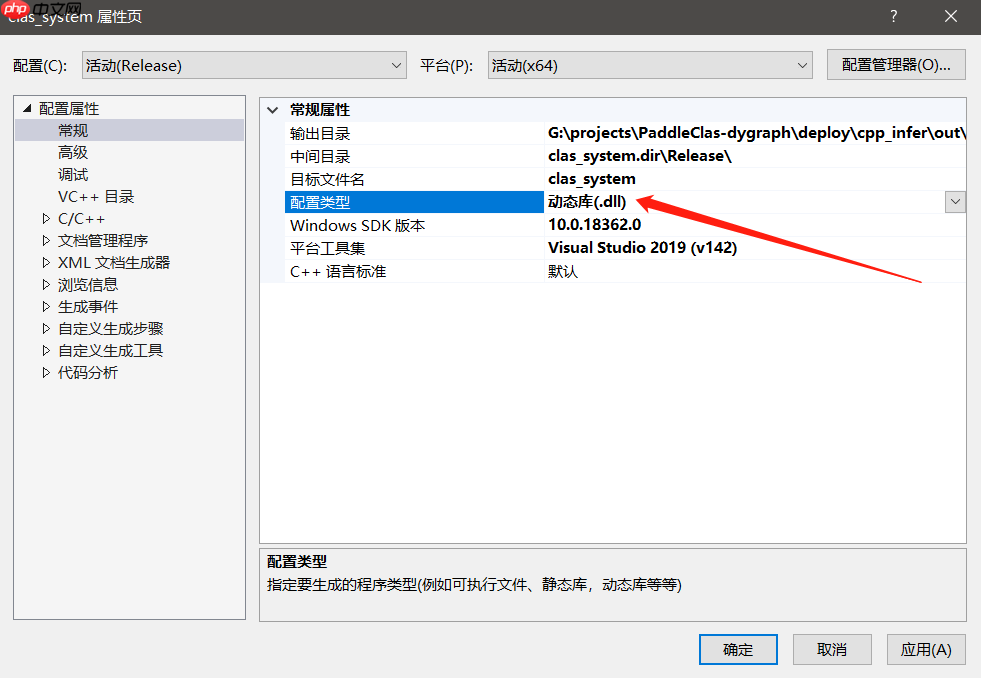

2.3 修改属性

打开该sln后,在属性—常规—配置类型中修改成.dll文件,确定

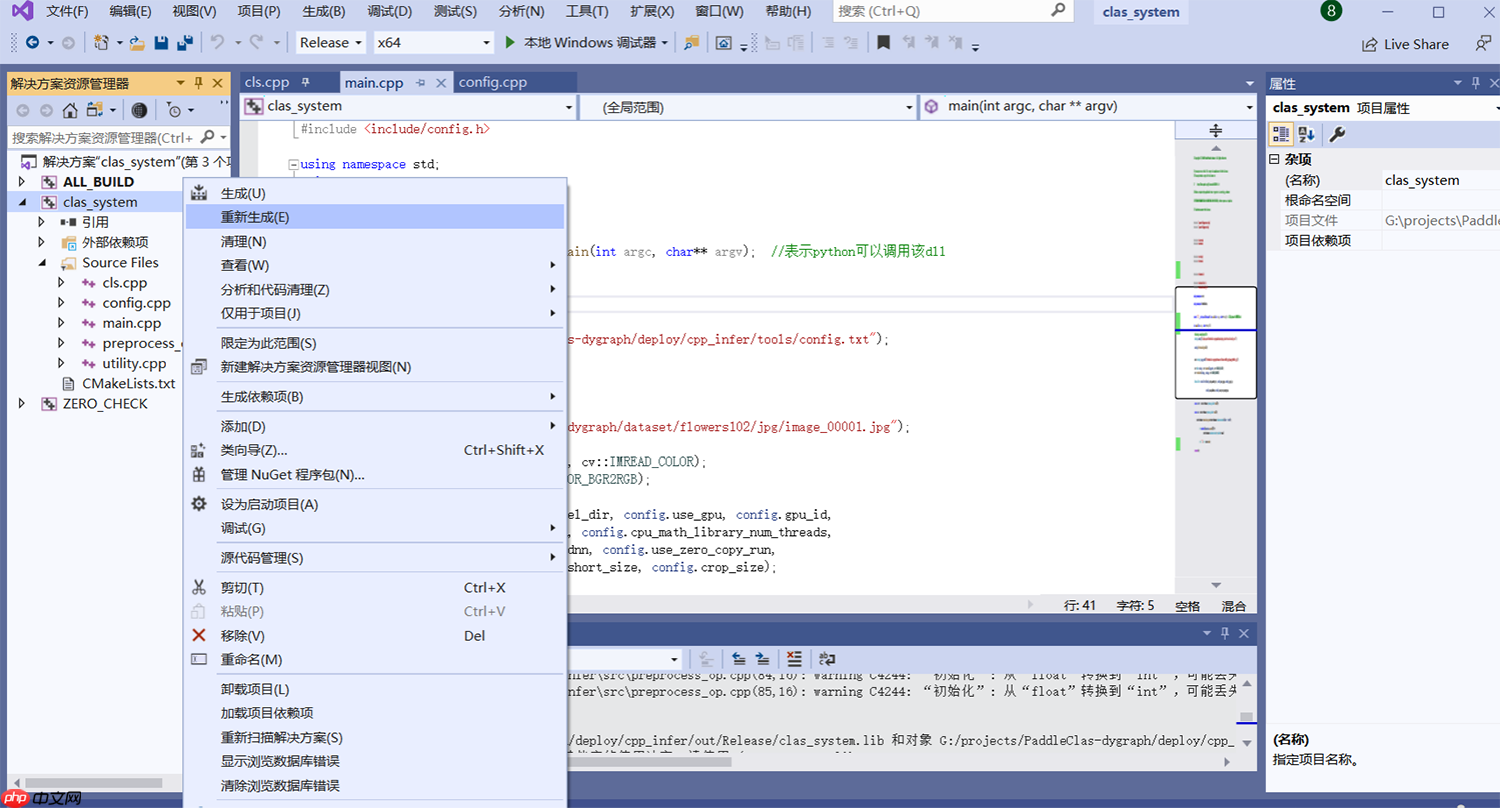

右键cls_system重新生成

待生成成功

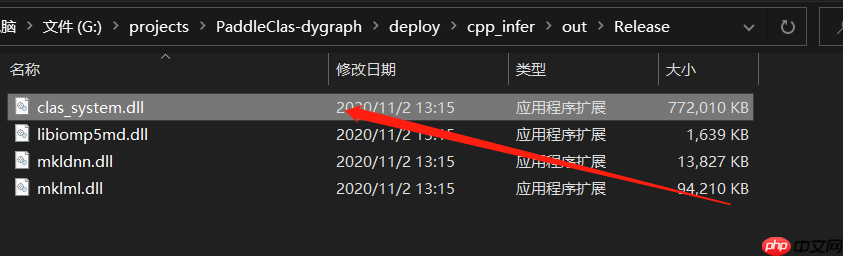

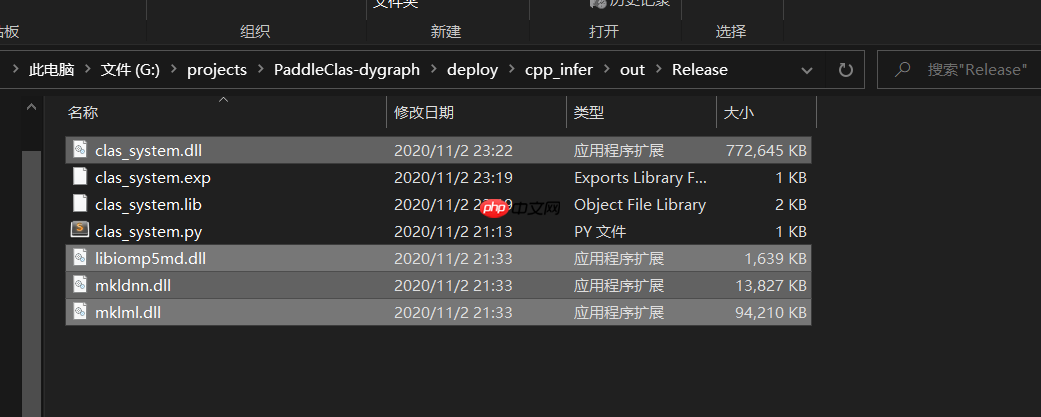

然后我们打开release目录,会发现有clas_system.dll文件

您以为这就好了?不,还要改嘞!!!

2.4 修改main.cc

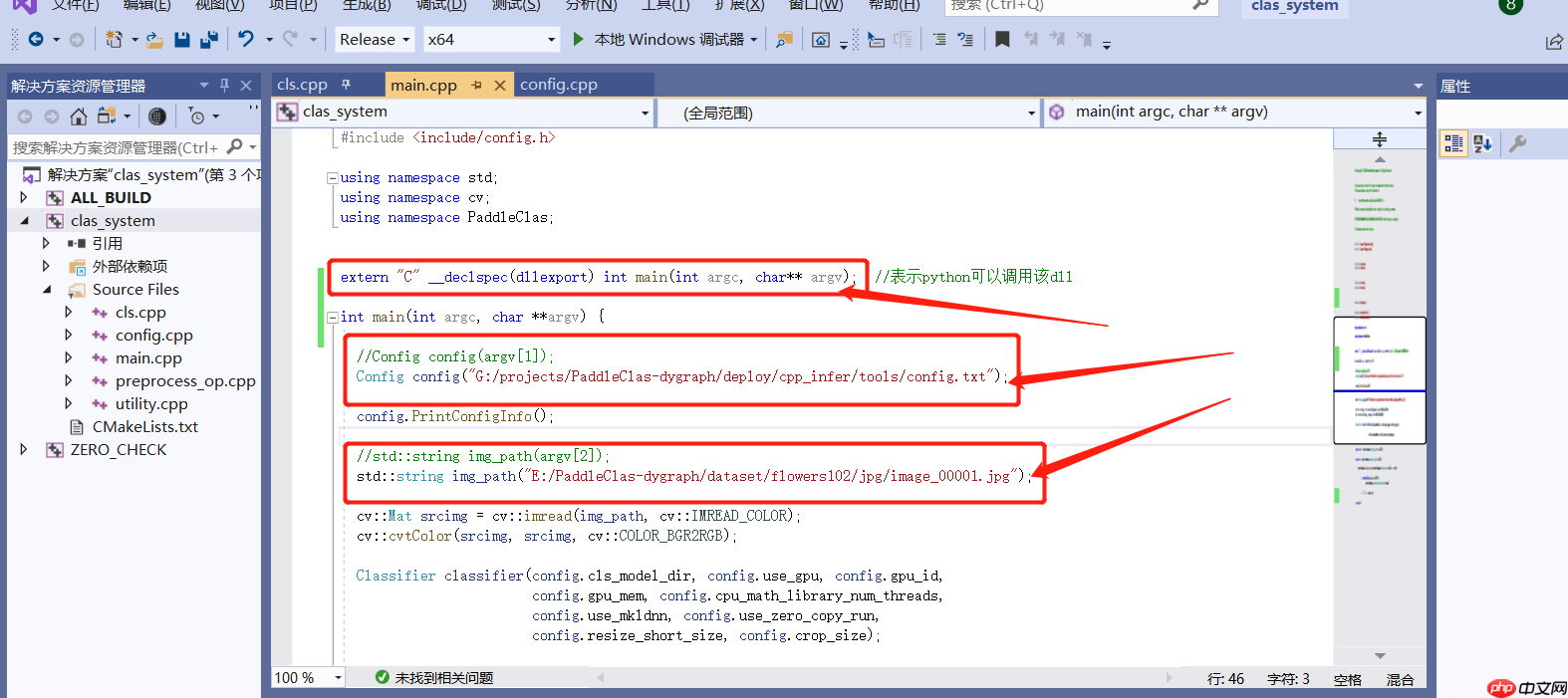

在main.cc文件内添加代码:

1.在int main(int argc, char **argv) 代码上方添加如下代码:

extern "C" __declspec(dllexport) int main(int argc, char** argv); //表示python可以调用该dll

2.把Config config(argv[1]); 改为:

Config config("G:/projects/PaddleClas-dygraph/deploy/cpp_infer/tools/config.txt");

该路径为预测配置文件路径

3.把std::string img_path(argv[2]); 改为:

std::string img_path("E:/PaddleClas-dygraph/dataset/flowers102/jpg/image_00001.jpg");

该路径为预测图片路径

4.删掉if (argc结果如下:

5.修改完成后重新生成...

2.5 python调用dll 预测

重新生成完成后,在release目录新建python文件:

内容为:

import ctypesfrom ctypes import *

dll=CDLL("clas_system.dll")print(dll.main())

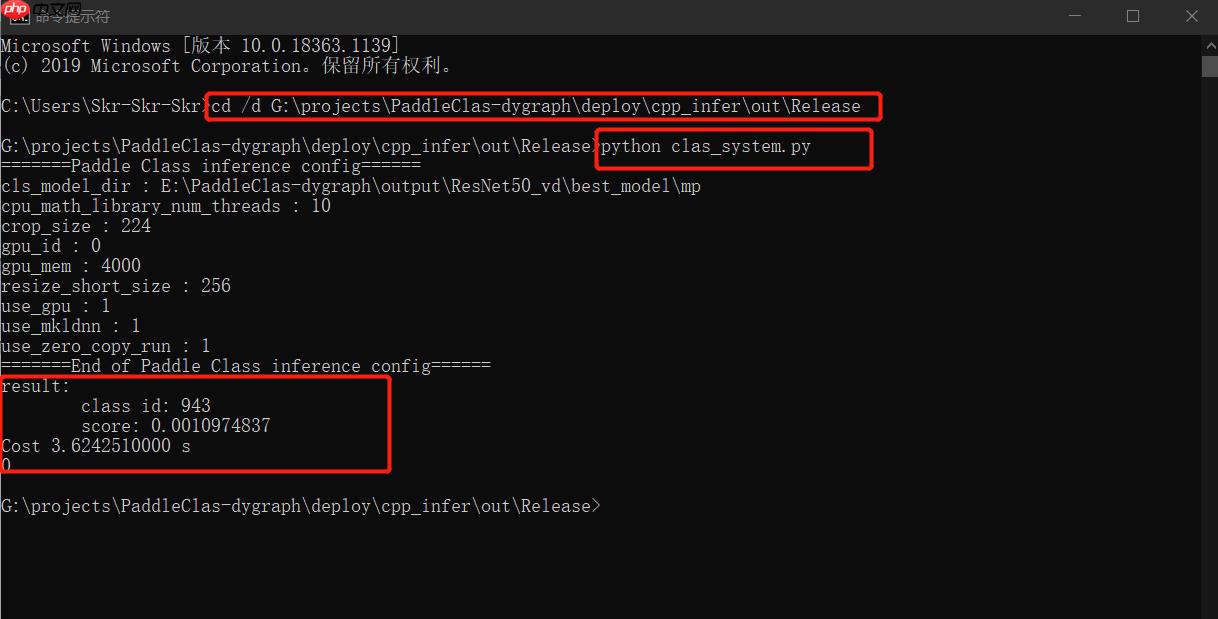

运行:

cmd 进入该目录,运行clas_system.py

预测结果如下。

到这里我们的python端调用dll预测流程已经完成。

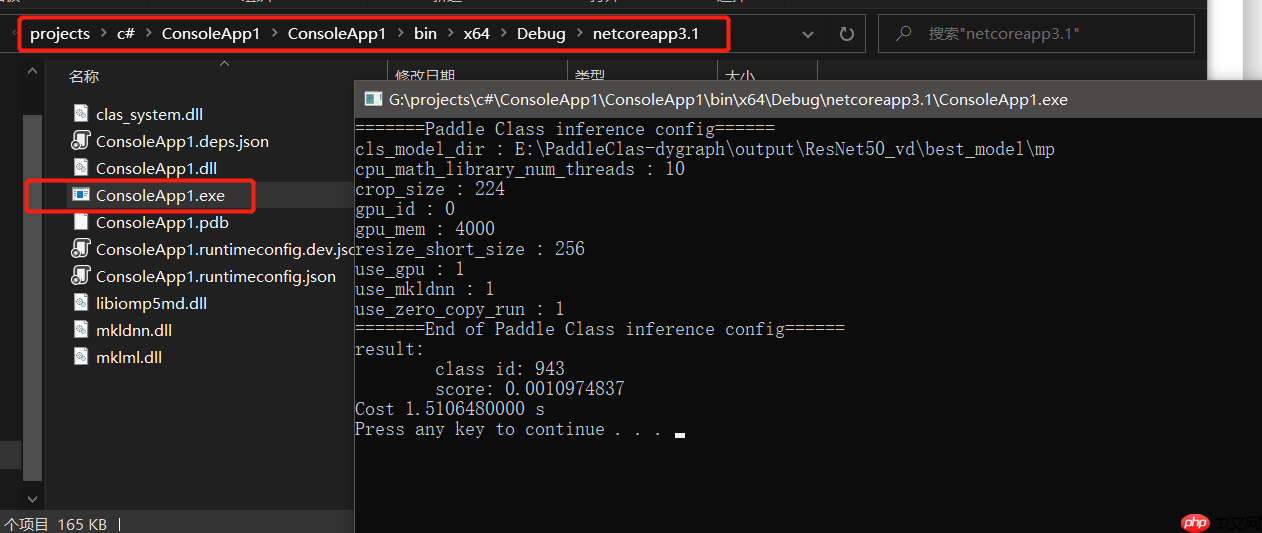

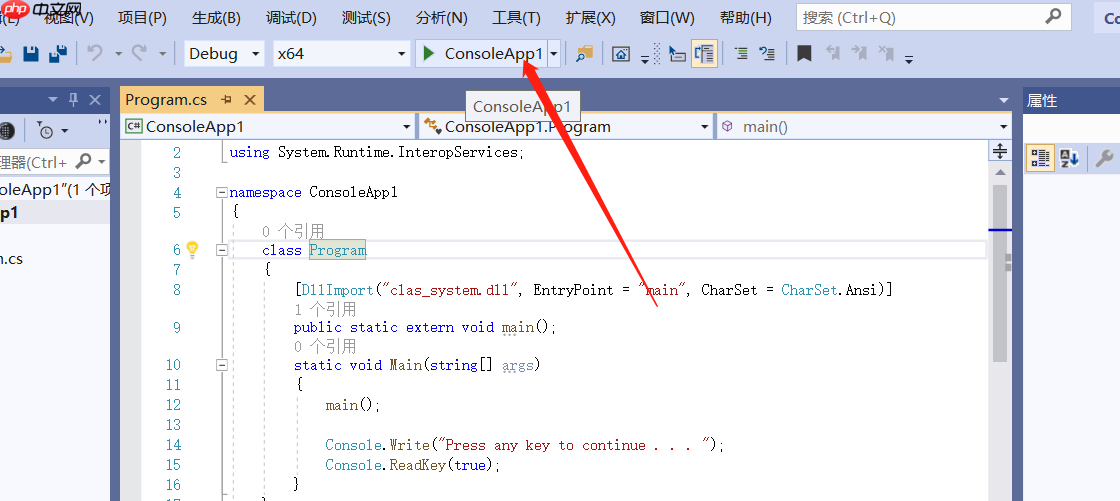

2.6 c#调用dll预测

1.创建c#控制台应用

2.修改代码如下:

using System;using System.Runtime.InteropServices;namespace ConsoleApp1

{ class Program

{

[DllImport("clas_system.dll", EntryPoint = "main", CharSet = CharSet.Ansi)] public static extern void main(); static void Main(string[] args)

{ main(); Console.Write("Press any key to continue . . . "); Console.ReadKey(true);

}

}

}

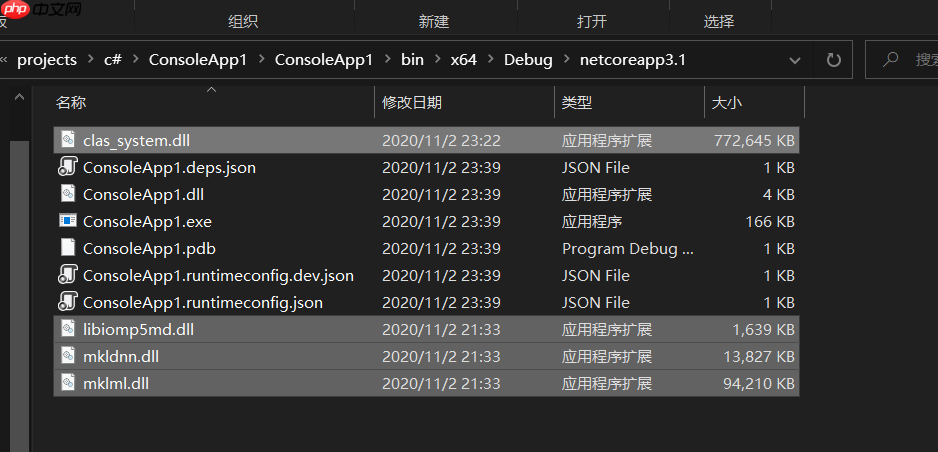

3.将我们之前在release目录中生成的dll全部复制到新建的控制台项目中

目录为:.......\ConsoleApp1\ConsoleApp1\bin\x64\Debug\netcoreapp3.1

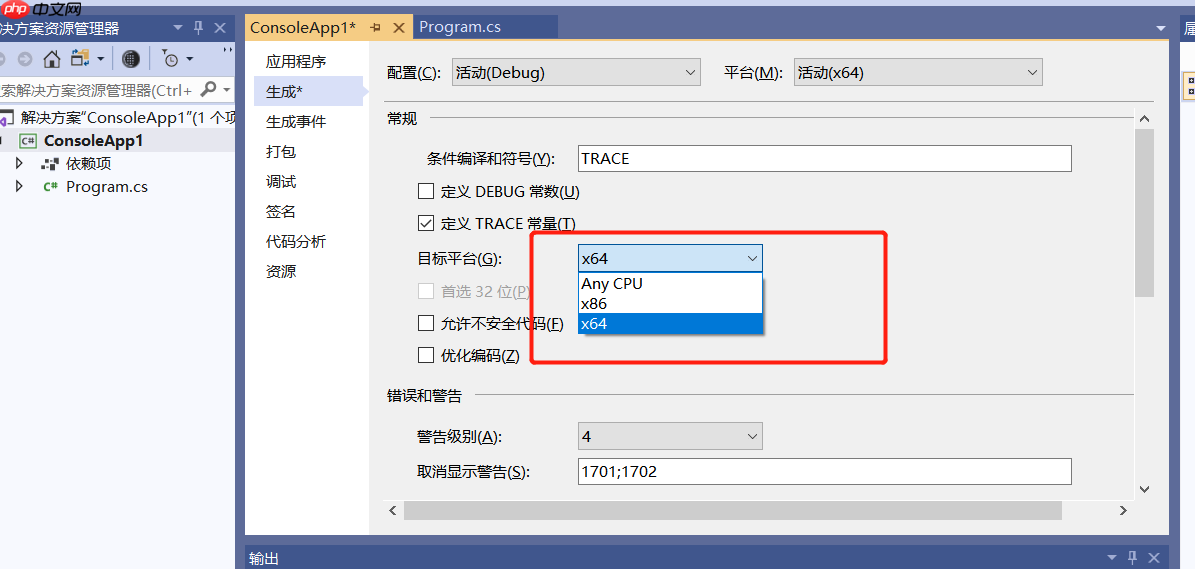

4.Debug编译

编译前需要修改下 “解决方案平台”

ConsoleApp属性->生成->目标平台->x64

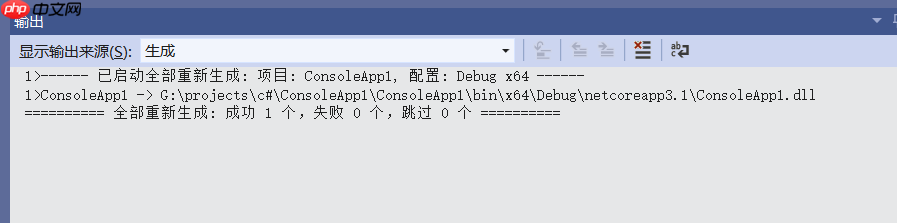

修改完成后,重新生成

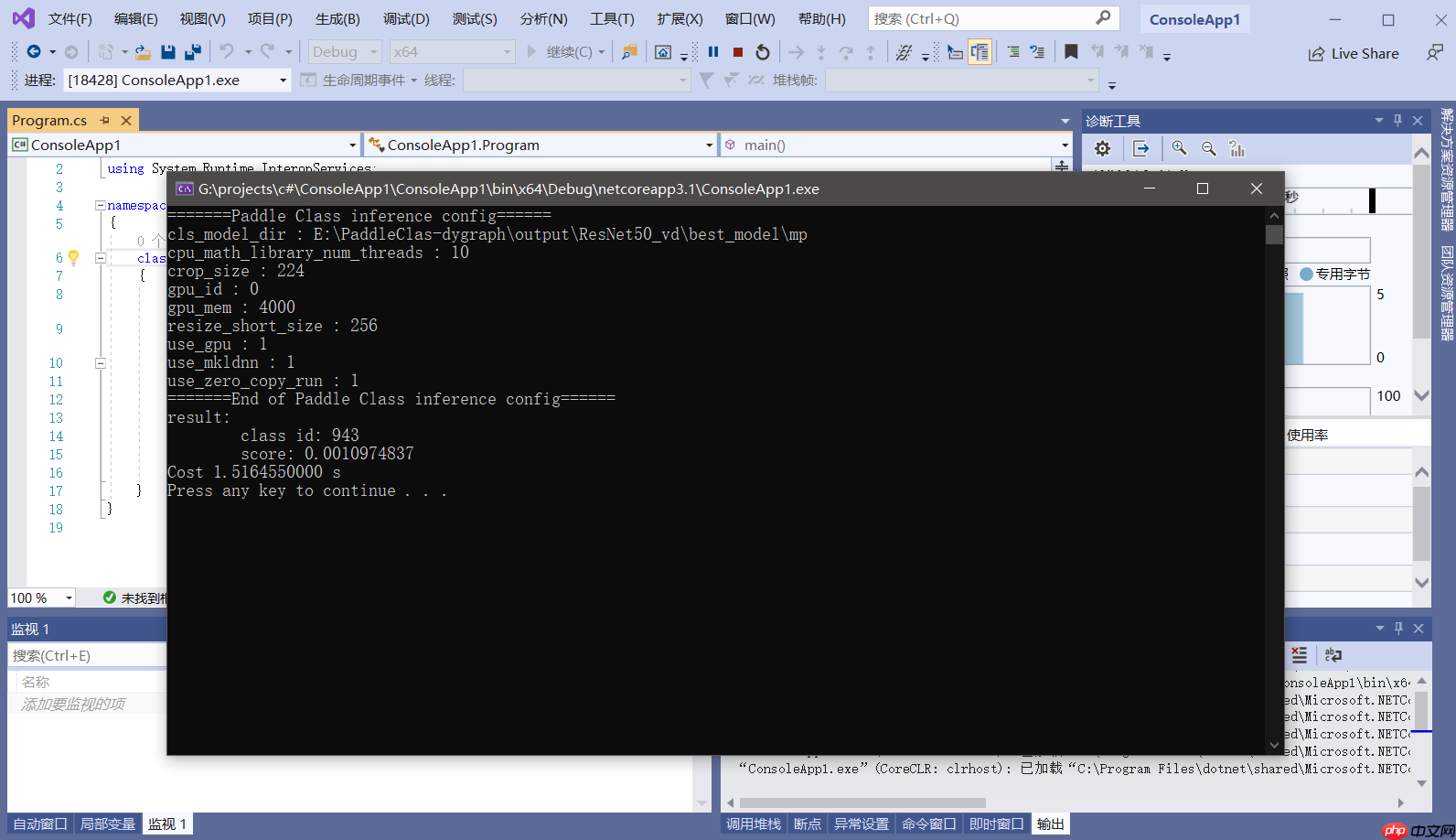

单击上方 ConsoleApp1 运行

成功输出预测结果,当然,我们生成的程序存放在目录G:\projects\c#\ConsoleApp1\ConsoleApp1\bin\x64\Debug\netcoreapp3.1下面直接打开该exe文件也可预测