queue.queue不能用于协程场景,因为它基于线程阻塞而非协程挂起,不支持await;应改用asyncio.queue,其通过协程挂起实现背压与异步等待。

为什么 queue.Queue 不能直接用于协程场景

因为 queue.Queue 是线程安全的阻塞队列,内部用 threading.Condition 实现等待,它会阻塞整个线程——而 asyncio 要求所有等待必须是协程友好的、不阻塞事件循环的。你用 await queue.get() 会报 TypeError: object Queue can't be used in 'await' expression。

实操建议:

立即学习“Python免费学习笔记(深入)”;

- 同步逻辑(多线程任务分发):用

queue.Queue,配合threading.Thread和queue.get(block=True) - 异步逻辑(Web 请求处理、后台任务调度):换用

asyncio.Queue,它原生支持await queue.get()和await queue.put() - 别混用:不要在

async def函数里调queue.Queue.put()并期望它“自动 await”,它根本不会让出控制权

asyncio.Queue 的背压控制怎么生效

它不像 queue.Queue(maxsize=...) 那样靠阻塞线程来限流,而是靠协程挂起实现背压:当队列满时,await queue.put(item) 会暂停当前协程,直到有空间;当为空时,await queue.get() 暂停直到有数据。这能让生产者和消费者自然速率匹配。

实操建议:

立即学习“Python免费学习笔记(深入)”;

- 初始化时显式设

maxsize,比如asyncio.Queue(maxsize=100),否则默认无上限,内存可能涨爆 - 消费者别用

while True: item = await q.get(); q.task_done()却忘了await q.join(),否则q.join()永远不会返回 - 多个消费者时,每个完成任务后必须调

q.task_done(),否则q.join()不知道任务是否真结束了

如何安全地把旧代码里的 queue.Queue 迁移到 asyncio.Queue

不是简单替换类名就行。同步队列的使用模式(如轮询、超时重试、多线程共享)和异步队列的协作式调度逻辑完全不同,强行套用会导致死锁或资源泄漏。

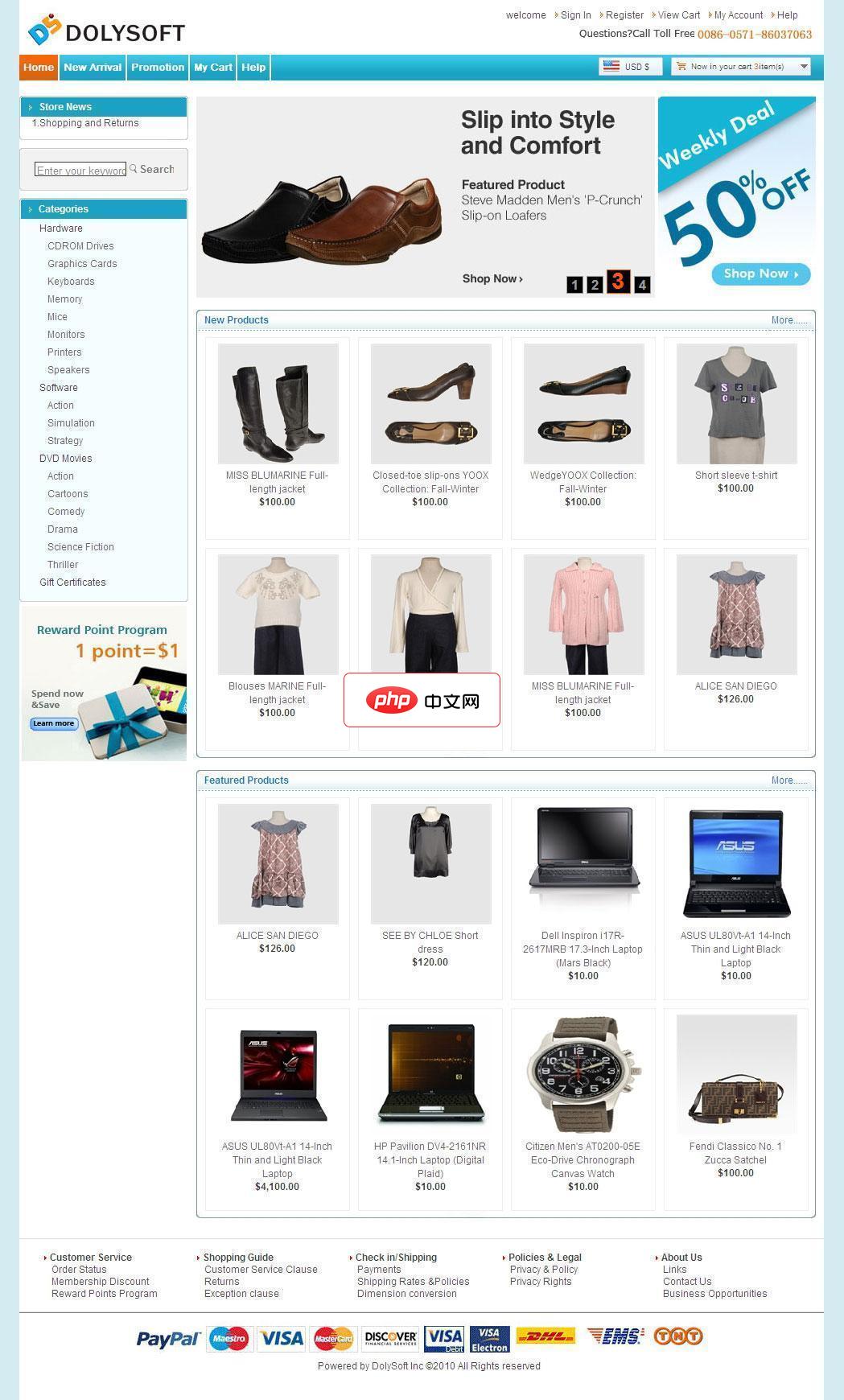

多瑞外贸网店系统立足于全球化贸易往来的一款外贸类企业用户高端应用电子商务系统软件,帮助企业快速搭建网聚全球商机的电子商务系统。本系统使用纯正的英文,国外用户更容易阅读;多年专业外贸设计经验,熟练掌握美式英语,更符合国外用户考虑和解决问题的逻辑;设计风格、用户体验符合国外用户的习惯;简洁明了的设计风格正是欧美用户的所爱,时时推出新模板、紧跟时尚潮流,供您选择。新增加淘宝数据自动导入,批量上传商品,商

实操建议:

立即学习“Python免费学习笔记(深入)”;

- 检查所有

q.get(timeout=...):异步对应的是await asyncio.wait_for(q.get(), timeout=...),不是q.get(timeout=...) - 移除所有

q.empty()或q.qsize()判断:它们在异步中不可靠(竞态),应依赖await q.get()的自然阻塞 - 原来用

queue.Queue做跨线程通信?现在得用asyncio.to_thread()包装同步函数,再用asyncio.Queue在协程间传参

用 asyncio.Queue 解耦 Web 请求和数据库写入时的典型陷阱

常见错误是启动一个“永远运行”的消费者协程去 await q.get(),但没做异常隔离,导致一个失败的数据库操作让整个消费者崩溃退出,后续消息全积压。

实操建议:

立即学习“Python免费学习笔记(深入)”;

- 消费者内部必须包

try/except,尤其捕获asyncio.TimeoutError和数据库驱动抛出的异常,失败项可记录日志或丢进死信队列 - 别在消费者里直接

await db.execute(...)后就完事,要加q.task_done()—— 而且必须放在finally块里,确保无论成功失败都标记完成 - 如果写入耗时波动大,考虑用

asyncio.Semaphore限制并发写入数,避免 DB 连接池打满,而不是只靠队列长度限流

队列本身不解决业务复杂度,它只是把“谁负责什么时候做什么”显式拆开。真正难的是界定边界:哪些该进队列,哪些该立刻响应,失败后要不要重试、重试几次、谁来兜底。这些没法靠换一个 Queue 类型自动对齐。